PaliGemma 正式发布 — Google 最新发布的前沿开放视觉语言模型

2024-05-18

阅读 9 分钟

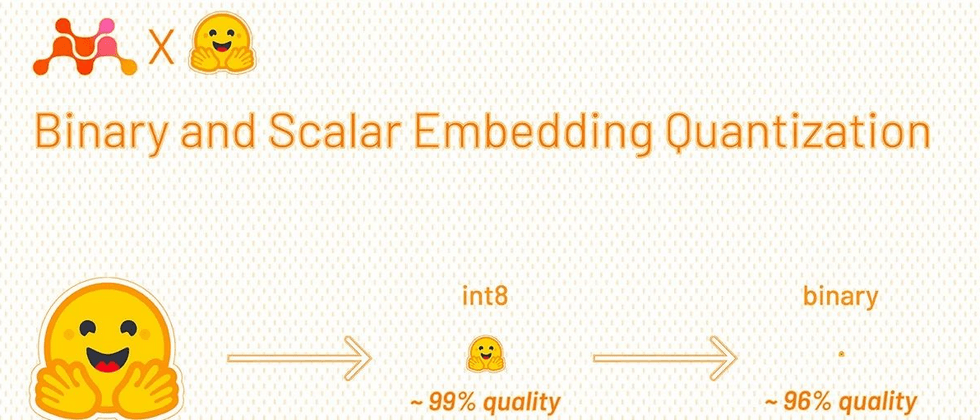

623PaliGemma(Github)是一系列具有视觉和语言处理能力的模型,由 SigLIP-So400m 作为图像编码器和 Gemma-2B 作为文本解码器构成。SigLIP 是一个顶尖的模型,可以同时解析图像和文本。它的工作方式类似于 CLIP,包括图像和文本编码器的联合训练。与 PaLI-3相似,PaliGemma 模型在图像-文本数据上进行预训练后,可轻松针对...