引言

在开发或者面试过程中,时常遇到过海量数据需要查询,秒杀时缓存击穿怎么避免等等这样的问题呢?掌握好本篇介绍的知识点将有助于你在之后的工作、面试中策马奔腾。

Bloom Filter概念

Bloom Filter,即传说中的布隆过滤器。它实际上是一个很长的二进制向量和一系列随机映射函数。布隆过滤器可以用于检索一个元素是否在一个集合中。它的优点是空间效率和查询时间都远远超过一般的算法,缺点是有一定的误识别率和删除困难。

Bloom Filter的原理

布隆过滤器的原理是,<font color="red">当一个元素被加入集合时,通过K个散列函数将这个元素映射成一个位数组中的K个点,把它们置为1。检索时,我们只要看看这些点是不是都是1就(大约)知道集合中有没有它了:如果这些点有任何一个0,则被检元素一定不在;如果都是1,则被检元素很可能在。</font>这就是布隆过滤器的基本思想。

Bloom Filter跟单哈希函数Bit-Map不同之处在于:Bloom Filter使用了k个哈希函数,每个字符串跟k个bit对应。从而降低了冲突的概率。

缓存击穿

Bloom Filter在避免缓存击穿中的应用方法:简而言之就是先把我们数据库的数据都加载到我们的过滤器中,比如数据库的id现在有:1,2,3...,n,以上面的原理图为例,将id所有值 经过三次hash之后,将hash得到的结果对应的地方由0修改为1。这样做之后,每次请求过来通过id查询数据,如果缓存没有命中,再在过滤器中查询,通过同样的hash算法将请求的id值进行运算,获得三个索引值,如果有任何一个对应索引的值为0,说明MySQL中也不存在该id,则直接报错返回。

<font color="#E96900">试想想这样做的好处是什么?假设这样的一种场景,如果有1000个参数非法请求同时访问(所谓参数非法是指数据库也不存在这类的值,比如id全为负值),缓存中都没有命中,此时如果这1000个请求同时打到DB,数据库层是扛不住的,所以此时Bloom Filter就显得十分必要。</font>

Bloom Filter的缺点

Bloom Filter之所以能做到在时间和空间上的效率比较高,是因为牺牲了判断的准确率、删除的便利性

- 存在误判,可能要查到的元素并没有在容器中,但是hash之后得到的k个位置上值都是1。如果Bloom Filter中存储的是黑名单,那么可以通过建立一个白名单来存储可能会误判的元素。

- 删除困难。一个放入容器的元素映射到bit数组的k个位置上是1,删除的时候不能简单的直接置为0,可能会影响其他元素的判断。

## Bloom Filter 实现

在实现Bloom Filter时,绕不过的两点就是hash函数的选取以及bit数组的大小。

对于一个确定的场景,我们预估要存的数据量为n,期望的误判率为fpp,然后需要计算我们需要的Bit数组的大小m,以及hash函数的个数k,并选择hash函数。

1 Bit数组大小选择

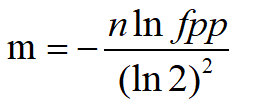

根据预估数据量n以及误判率fpp,bit数组大小的m的计算方式:

2 哈希函数选择

由预估数据量n以及bit数组长度m,可以得到一个hash函数的个数k:

3 应用测试

本篇采用的是Google的Bloom Filter,首先需要引入jar包:

<dependency>

<groupId>com.google.guava</groupId>

<artifactId>guava</artifactId>

<version>23.0</version>

</dependency> 测试分两步:

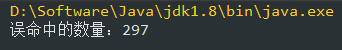

1、往过滤器中放五千万个数,然后去验证这五千万个数是否能顺利通过过滤器;

2、另外找一万个不在过滤器中的数,检查Bloom Filter误判的几率。

import com.google.common.hash.BloomFilter;

import com.google.common.hash.Funnels;

/**

* @author Carson Chu

* @date 2020/3/15 14:48

* @description 布隆过滤器测试样例

*/

public class BloomFilterTest {

private static int capacity = 50000000;

private static BloomFilter<Integer> bf = BloomFilter.create(Funnels.integerFunnel(), capacity);

// private static BloomFilter<Integer> bf = BloomFilter.create(Funnels.integerFunnel(), total, 0.001);

public static void main(String[] args) {

// 初始化50000000条数据到过滤器中

for (int i = 0; i < capacity; i++) {

bf.put(i);

}

// 匹配已在过滤器中的值,是否有匹配不上的

for (int i = 0; i < capacity; i++) {

if (!bf.mightContain(i)) {

System.out.println("有坏人逃脱了~~~");

}

}

// 匹配不在过滤器中的10000个值,有多少匹配出来

int count = 0;

for (int i = capacity; i < capacity + 10000; i++) {

if (bf.mightContain(i)) {

count++;

}

}

System.out.println("误命中的数量:" + count);

}

}

运行结果表示,遍历这五千万个在过滤器中的数时,都被识别出来了。一万个不在过滤器中的数,误伤了297个,误判率是2.9%左右。

如果想要降低误判率该怎么做呢,不要急,源码为我们提供了这一机制:

@CheckReturnValue

public static <T> BloomFilter<T> create(Funnel<? super T> funnel, int expectedInsertions) {

return create(funnel, (long)expectedInsertions);

}

@CheckReturnValue

public static <T> BloomFilter<T> create(Funnel<? super T> funnel, long expectedInsertions) {

return create(funnel, expectedInsertions, 0.03D);

}

@CheckReturnValue

public static <T> BloomFilter<T> create(Funnel<? super T> funnel, int expectedInsertions, double fpp) {

return create(funnel, (long)expectedInsertions, fpp);

}

@CheckReturnValue

public static <T> BloomFilter<T> create(Funnel<? super T> funnel, long expectedInsertions, double fpp) {

return create(funnel, expectedInsertions, fpp, BloomFilterStrategies.MURMUR128_MITZ_64);

}

/* create()方法的最底层实现 */

@VisibleForTesting

static <T> BloomFilter<T> create(Funnel<? super T> funnel, long expectedInsertions, double fpp, BloomFilter.Strategy strategy) {

Preconditions.checkNotNull(funnel);

Preconditions.checkArgument(expectedInsertions >= 0L, "Expected insertions (%s) must be >= 0", new Object[]{expectedInsertions});

Preconditions.checkArgument(fpp > 0.0D, "False positive probability (%s) must be > 0.0", new Object[]{fpp});

Preconditions.checkArgument(fpp < 1.0D, "False positive probability (%s) must be < 1.0", new Object[]{fpp});

Preconditions.checkNotNull(strategy);

if (expectedInsertions == 0L) {

expectedInsertions = 1L;

}

long numBits = optimalNumOfBits(expectedInsertions, fpp);

int numHashFunctions = optimalNumOfHashFunctions(expectedInsertions, numBits);

try {

return new BloomFilter(new BitArray(numBits), numHashFunctions, funnel, strategy);

} catch (IllegalArgumentException var10) {

throw new IllegalArgumentException("Could not create BloomFilter of " + numBits + " bits", var10);

}

}BloomFilter一共四个create方法,不过最终都是走向第四个。看一下每个参数的含义:funnel:数据类型(一般是调用Funnels工具类中的)expectedInsertions:期望插入的值的个数fpp:错误率(默认值为0.03)strategy :Bloom Filter的算法策略

错误率越大,所需空间和时间越小,错误率越小,所需空间和时间约大。

Bloom Filter的应用场景

- cerberus在收集监控数据的时候, 有的系统的监控项量会很大, 需要检查一个监控项的名字是否已经被记录到DB过了,如果没有的话就需要写入DB;

- 爬虫过滤已抓到的url就不再抓,可用Bloom Filter过滤;

- 垃圾邮件过滤。如果用哈希表,每存储一亿个email地址,就需要1.6GB的内存(用哈希表实现的具体办法是将每一个email地址对应成一个八字节的信息指纹,然后将这些信息指纹存入哈希表,由于哈希表的存储效率一般只有 50%,因此一个email地址需要占用十六个字节。一亿个地址大约要 1.6GB,即十六亿字节的内存)。因此存贮几十亿个邮件地址可能需要上百GB的内存。而Bloom Filter只需要哈希表 1/8到 1/4 的大小就能解决同样的问题。

总结

布隆过滤器主要是在解决缓存穿透问题的时候引出来的,了解他的原理并能实习运用,在开发和面试中都是大有裨益的。

**粗体** _斜体_ [链接](http://example.com) `代码` - 列表 > 引用。你还可以使用@来通知其他用户。