1. Summary

文章主要介绍了NER的资源(NER语料及工具),并从distributed representation for input,context encoder和tag decoder三个维度介绍了目前现有的工作,并调研了目前最具代表性的深度学习方法。最后提出了目前NER系统面临的挑战以及未来的研究方向。

2. Introduction

(1) NEs通常分为两种:generic NEs (e.g., person and location) and domain-specific NEs (e.g., proteins, enzymes, and genes)。

(2) 主流NER方法有以下四种:

- Rule-based approaches: which do not need annotated data as they rely on hand-crafted rules.

- Unsupervised learning approaches: which rely on unsupervised algorithms without hand-labeled training examples.

- Feature-based supervised learning approaches: which rely on supervised learning algorithms with careful feature engineering.

- Deep-learning based approaches: which automatically discover representations needed for the classification and/or detection from raw input in an end-to-end manner.

3. Motivation

近年来深度学习方法在多个领域取得巨大的成功,在NER系统上应用深度学习方法也成功在多个NER任务上达成SOTA。作者期望通过比较不同的深度学习架构,以获知哪些因素影响了NER的性能。

4. Content

本文可视作NER系统的百科全书,非常详尽地介绍了NER的概念,传统方法以及深度学习方法。

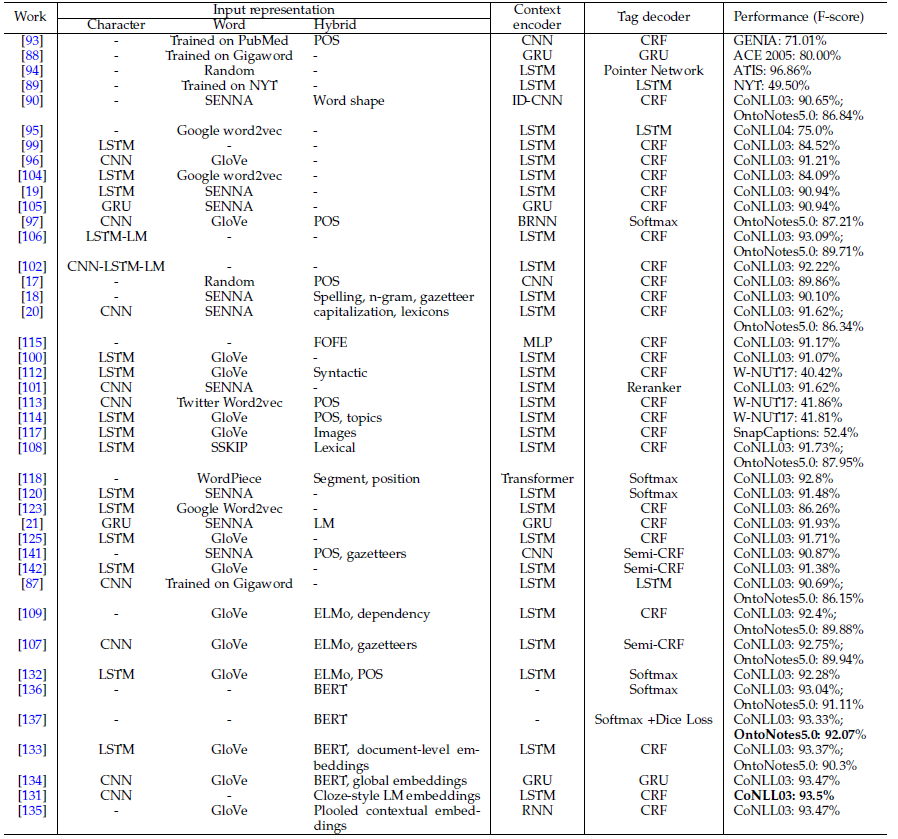

- Input Representation通常包括word-level、character-level、hybrid等表征方式,最近较新的有sub-word级别的表征,可视作word和character级别间的折中。

- Context Encoder包括了CNN、RNN、Transformer等网络结构,如今使用预训练embedding的Transformer正成为NER一种新的范式。

- Tag Decoder常用的有MLP+Softmax、CRF、RNN和Pointer network。

- 基于DL的NER性能在很大程度上取决于Input Representation,引入额外知识可以提升模型性能,然而是否应该引入额外知识在学界并没有达成一致。引入额外知识会影响端到端的学习和模型的通用性。此外,基于Transformer的NER系统在不使用预训练embedding和训练数据量较小时表现欠佳。

- 同时,文章还简要介绍了使用多任务学习、迁移学习、主动学习(active learning)、强化学习和对抗学习(adversarial learning)等方法来实现NER系统。

目前在CoNLL03数据集上,Cloze-driven pretraining of self-attention networks达到SOTA(F-score93.5%);在OntoNotes5.0数据上BERT+Dice loss达到SOTA(F-score92.07%)。一些模型在NER数据上的性能表现如下:

5. Challenges and Future Directions

- 挑战主要包括因语言歧义性(language ambiguity)带来标注语料质量与一致性的下降,以及识别非正式文体(如tweeter和微博短评)以及语料中没见过的实体。

- 本文提到可能的未来方向有:细粒度NER和边界检测、NER与实体联合链接、利用附加资源解决非正式文体的实体识别、基于深度学习方法的NER可拓展性(参数量太大)、使用迁移学习的NER、易于使用的NER工具包。

**粗体** _斜体_ [链接](http://example.com) `代码` - 列表 > 引用。你还可以使用@来通知其他用户。