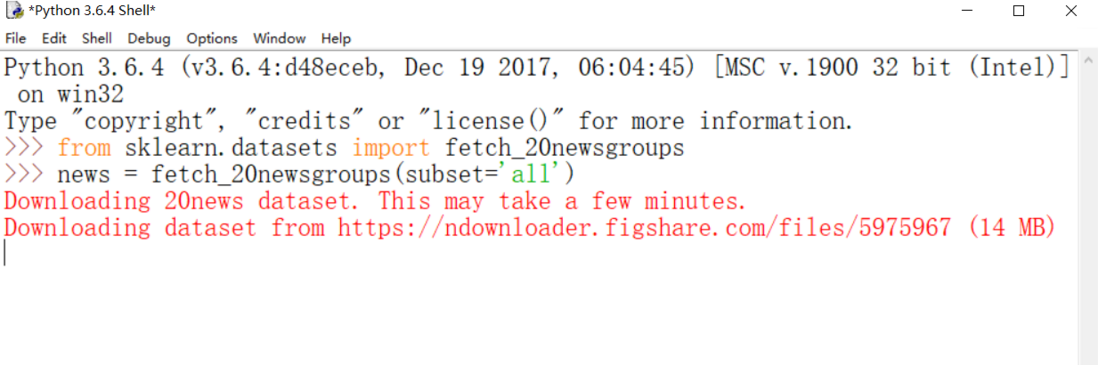

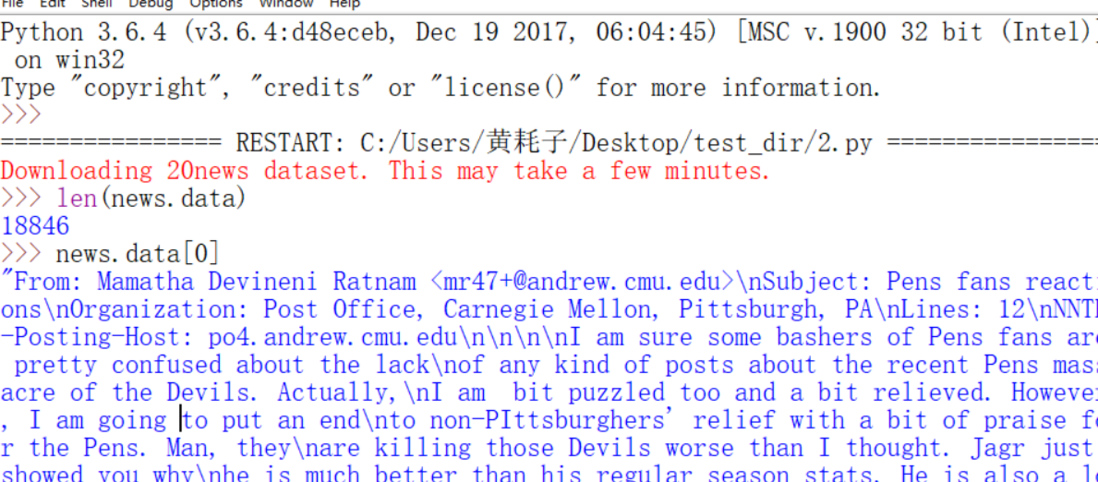

最近, 耗子我在做关于互联网新闻分类的项目, 需要用到sklearn.datasets里新闻数据抓取器fetch_20newsgroups, 而当将参数subset设置为'all'时, fetch_20newsgroups需要即时从互联网下载数据, So:

稍有python下载经验的就知道, 1M就得等很久了, 这是14M, 啊啊!

So:老办法一

直接复制图片中的网址下载:

https://ndownloader.figshare.com/files/5975967

然后, 依然很慢......

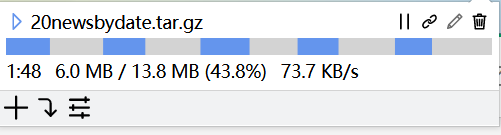

So:老办法二

复制链接, 用火狐浏览器插件多线程下载器下载

额, 也不算快啊......

So:老办法三

直接复制链接给迅雷呀!? 刚咋没想到呢????

行吧, 还算迅雷给力......

接下来。。。

问题又来了, 有文件了, Python 怎么读取啊???

文件名是 20newsbydate.tar.gz

然后我就搜了 Python如何读取gz文件

大概是我中午没睡好吧, 搜这干嘛......

几经波折, 终于找到了......

感谢大神的分享: 这里是原文

在此说明如下:

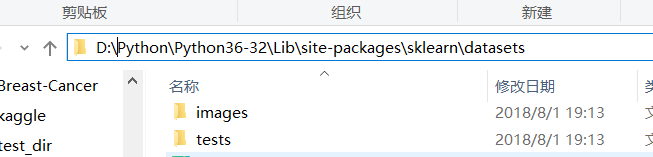

fetch_20newsgroups函数将下载的文件放在

C:\Users\(你的user_name)\scikit_learn_data\20news_home目录下

将你下载的文件放在这里

注:

Python下载的文件叫20new-sbydate.tar.gz

你下载的叫20newsbydate.tar.gz

所以改成它那样的就成

(不过自己应该先看下, 你那个版本的Python下载的文件名字是啥)

进入Python安装文件夹中找到文件 twenty_newsgroups.py

用任意文本编辑器打开它

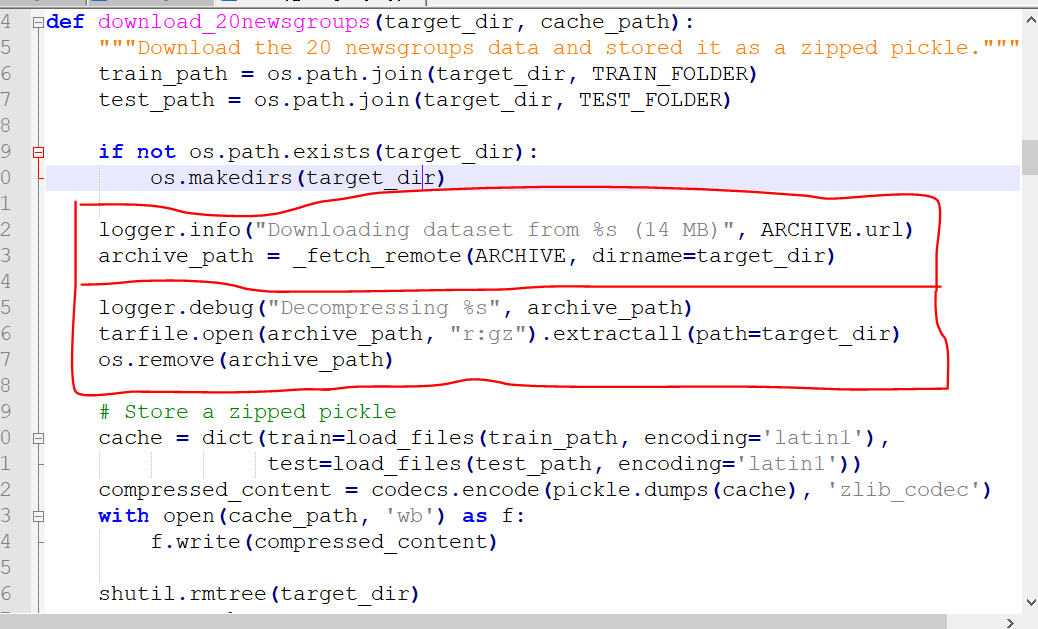

找到download_20newsgroups函数

上红框是下载文件的部分, 下红框是解压文件的部分

So, 我们只需要将上红框注释掉, 并加入文件地址即可

然后, ctrl+s , 如图:

有可能再报一个缩进的错:

缩进嘛, 看下哪行的4个空格变成一个Tab了, 改过来即可

**粗体** _斜体_ [链接](http://example.com) `代码` - 列表 > 引用。你还可以使用@来通知其他用户。