过去的一年见证了人类百年不遇的大事记,也见证了多种视频应用的厚积薄发。而因此所带来的视频数据量的爆发式增长更加加剧了对高效编解码这样的底层硬核技术的急迫需求。

新视频编解码标准 VVC 定稿不久之后,阿里巴巴的视频团队开始全力投入开展 VVC 软件编解码的开发工作。

在 LiveVideoStackCon 2021 北京峰会,阿里巴巴研究员,阿里云智能云视频标准与实现负责人叶琰老师展开分享视频业界现状、Ali266 自研 VVC 编解码器的技术演进史和业务展望、以及视频业界所面临的未来机遇和挑战。

文 | 叶琰

整理 | LiveVideoStack

大家好,我是叶琰,我是阿里云智能视频标准与实现团队负责人。本次分享的话题是编解码再进化:Ali266 与下一代视频技术。

本次分享分成四个部分:首先是视频业界现状、然后 Ali266 自研 VVC 编解码器的技术演进史和业务展望,最后会从视频业界角度来看所面临的未来机遇和挑战。

1. 视频业界现状

不夸张的说,过去一年和现在所经历的新冠疫情是人类百年不遇的大事。疫情打断了正常生活节奏和人与人之间习惯的面对面交流模式,改变了非常多游戏规则,同时触发了先进视频科技产品的厚积薄发。

全世界疫情情况各有不同,中国属于疫情控制非常好的国家,因此人民日常生活基本照常,但是在疫情较为严重的国家和地区,由于受到疫情影响,人们的生活和工作发生了天翻地覆的变化。

这些变化包括几个方面。首先无论是工作上的交互从线下转到线上,大量使用云会议,拿钉钉的视频会议来讲,到今天累计每天用户时长超过了一亿分钟。另外,受疫情影响比较严重的国家和地区过半员工在家办公,在家工作中通过远程协同进行,和之前所习惯的面对面交流有了很大变化。

不光是工作,人们的娱乐也从线下转到线上,拿美国来讲,在过去一年多电影院关门,虽然从今年夏天开始营业,但是看电影的人寥寥无几。大家的娱乐生活主要依赖于家庭影院,包括明星也从线下转到线上演出,通过线上交互方式与粉丝进行互动。

从视频业界的角度来说,我们在过去的一年见证了非常重要的里程碑,就是 H.266/VVC 新一代国际视频标准的定稿。VVC 标准是从 2018 年 4 月正式开始标准化,经过两年多时间,在 2020 年夏天达到 Final Draft International Standard,也就是第一版的定稿。

VVC 在整个两年多的旅程中,尤其最后半年,受到疫情影响,来自全世界各地近 300 名的视频专家日夜颠倒的参加通过网会的形式开展技术讨论,终于如期完成 H.266/VVC 新一代标准制定。

与之前每一代国际视频标准类似,VVC 相对于上一代 HEVC 标准带宽成本减半。

上图表示 VVC 主观性能测试结果,这里展示的是 VVC 参考平台相比于 HEVC 参考平台,在相同主观质量的前提下,VVC 所能做到的带宽节省。

这里面的视频内容分为 5 类,前两列为 UHD 和 HD,也就是超高清和高清视频,我们可以看到 VVC 的 VTM 参考软件相比于 HEVC 的 HM 参考软件可以达到 43% 到 49% 的带宽节省。

对于 HDR 和 360 全景视频这两种更加新颖的视频格式,VVC 可以做到更高的带宽节省,分别达到 51% 到 53%。

最后一列是针对于低延时应用的测试,也就是使用视频会议上所用的时域预测结构,由于预测结构收到了更多的限制,VVC 所能达到的带宽节省稍小,但也达到了 37%,相当可观。

篇幅有限,这里面只是展示了高度总结的数字,如果读者对中间细节感兴趣,可以去查一下 JVET 标准委员会 T/V/W2020 三个会议中主观测试集报告,其中有非常多的细节可供参考。

在视频爆发和最新标准 VVC 定稿的背景下,阿里巴巴开始了 Ali266 技术开发。首先看一下 Ali266 技术演进史。

2. Ali266 技术演进史

什么是 Ali266?我们希望它做到什么?

Ali266 是我们对最新标准 VVC 进行编解码实现,第一点希望做到高压缩性能,拿到 VVC 所带来的带宽节省红利;第二点是高清实时编码速度,相较于 HEVC,VVC 编码工具更多,保持实时编码速度对于真正商用来说具有巨大的意义;第三点是让 Ali266 具有完整的自成一体的编解码能力,更好打开端到端的生态。

做 Ali266 是希望实现上述三个非常有挑战的技术点,做到技术领先性,转换成产品竞争力,并帮助我们进行业务拓展。

上图展示了众多的 VVC 编码工具。我这里把传统的视频编解码框架中的主要功能模块分成几类,包括块划分、帧内预测、帧间预测、残差编码、变化量化、环路滤波、以及其他编码工具。

上面的蓝色圆圈是 HEVC 的编码工具,下面的紫色圆圈是 VVC 的编码工具。我们可以看到,在相应的功能模块中,HEVC 只有三四个相应编码工具,而 VVC 支持更加丰富的编码工具集,这也是它能够有强大的压缩能力并拿到带宽节省红利的主要原因。

编码工具都具有一定的复杂度,因此每增加一个编码工具都会相应带来复杂度和性能的上升。

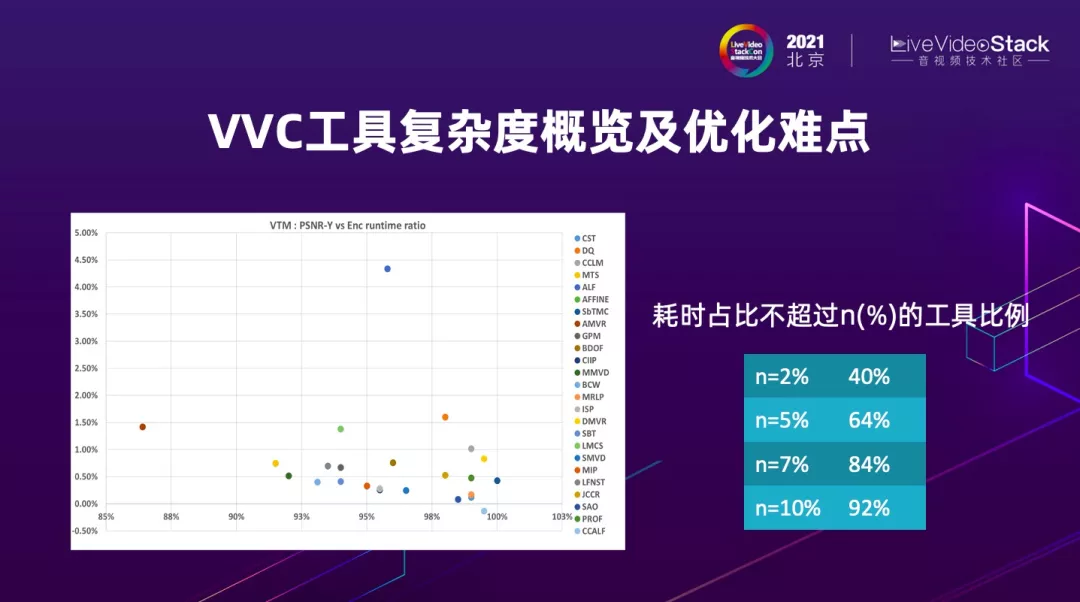

上图是 JVET 标准委员会在 VVC 标准开发期间跟踪的每个编码工具带来的复杂度和能提供的编码性能的全面概览图。

这个图中横轴是时间,纵轴是编码性能的上升,不同颜色点对应于不同的 VVC 编码工具。其中横轴越往右相当于一个编码工具的复杂度越低,纵轴越靠上说明编码工具带来的性能越高。

因此我们希望编码工具落在右上角,但其实从图中可以看到,VVC 编码工具基本上在右上角一片空白,更多的编码工具能够带来 1%、1.5% 的性能增益,但是也有小幅的复杂度上升。

这对于做编码器优化提出挑战,因为并不能只要抓住几个主要的编码工具进行优化就可以,而是要在丰富的编码工具集中,针对当前的输入视频能够快速准确选择应该使用的编码工具,这是做 H.266 编码器的主要优化难点。

上图右边的表展示的是在我们软编系统对不同编码工具耗时比进行 profile,相应于左边的图,再一次验证 40% 的编码工具的耗时都不多,只占了 2% 左右,但都提供性能,所以我们必须决定如何去选择。另外,92% 的编码工具的耗时都不到 10%,对整个工程算法上的优化提出挑战。

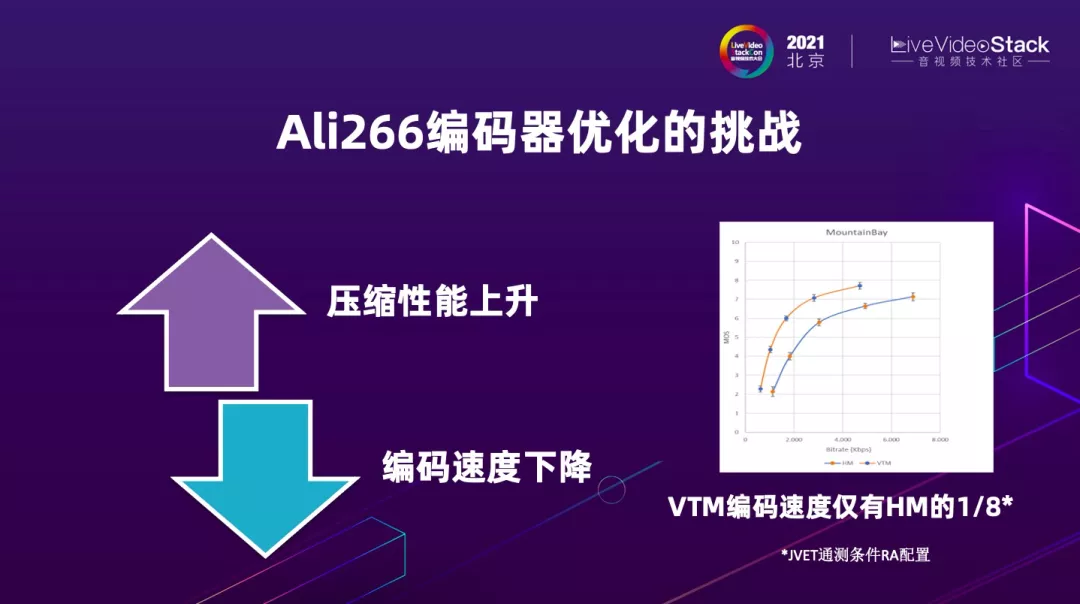

上图里面展示的不光是 H.266 编码器优化所受到的挑战,而是任何一个实时编码器都会受到的挑战。

因为在视频编码过程中,都要经历压缩性能上升、编码速度下降的拉锯战,所以我们要做的是克服这个拉锯战。

如果我们对比 VVC 参考平台 VTM 相比于 HEVC 参考平台 HM,虽然带宽减半,但是 VTM 的编码速度只有 HM 编码速度的八分之一,这是对实时编码是不能接受的,所以接下来我主要讲一下 Ali266 所进行的优化。

我们将从两个维度对优化工作进行介绍,首先是编码质量(编码性能)的优化。

编码质量(编码性能)优化

我们在编码质量和性能的保持上做了很多工作。由于篇幅有限,我只介绍一个例子,这里我选的是预分析、前处理、和核心编码工具的联合优化例子。

预分析选的是场景切换检测,做编码器的同学都知道每个商用编码器能够进行精准的场景切换检测非常有必要;前处理选的是 MCTF 过程,下文会简单介绍一下 MCTF 是什么;核心编码工具选的是 VVC 的新编码工具 LMCS。

这个是关于 MCTF 前处理过程的一个简介。

MCTF 是 motion conmpensated temporal filtering 的意思,它是通过逐层运动搜索和运动补偿对输入视频信号进行时域上滤波,通过双边滤波器做时域上的滤波,可以进行有效的进行视频降噪,并且降噪在时域上发生的同时在空域上也起到降噪的效果。

MCTF 可以有效提升编码效率,正是因为如此,VTM 和 VVEnc(VVC 的开源编码器)平台上都有支持 MCTF 这个前处理过程。

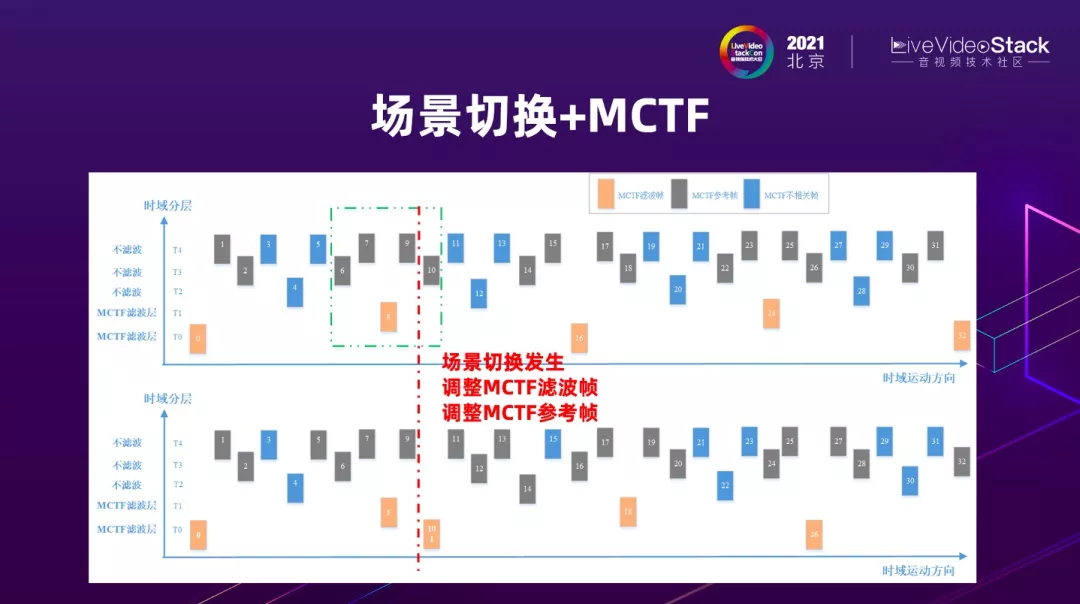

那么我们看一下场景切换和 MCTF 如何进行结合。

上图展示编码器在浅黄低时域层视频帧上进行 MCTF,由于 MCTF 要使用时域上的运动补偿和搜索,每个浅黄色的帧都有相应的浅灰的帧作为 MCTF 的参考帧,而浅蓝色的帧与 MCTF 没有关系。由于有时域参考的关系,因此遇到场景切换时需要对 MCTF 进行修改。

我们可以看到,在正常情况下,第八帧是 MCTF 帧,它的前后两帧共四帧是 MCTF 参考帧。遇到场景切换情况,比如在第十帧遇到场景切换,本来第十帧是 MCTF 参考帧,但是由于场景切换,第十帧会变成新的 I 帧,它的时域层相应下降,原来的 MCTF 滤波帧和 MCTF 参考帧必须进行调整,也就是浅黄色和浅灰色的帧会有调整。上下对比可以看见,因为场景切换,第八帧的 MCTF 参考帧调整为它的前三帧和后一帧,而第十帧变成 MCTF 滤波帧,其使用的 MCTF 参考帧为它的后四帧。

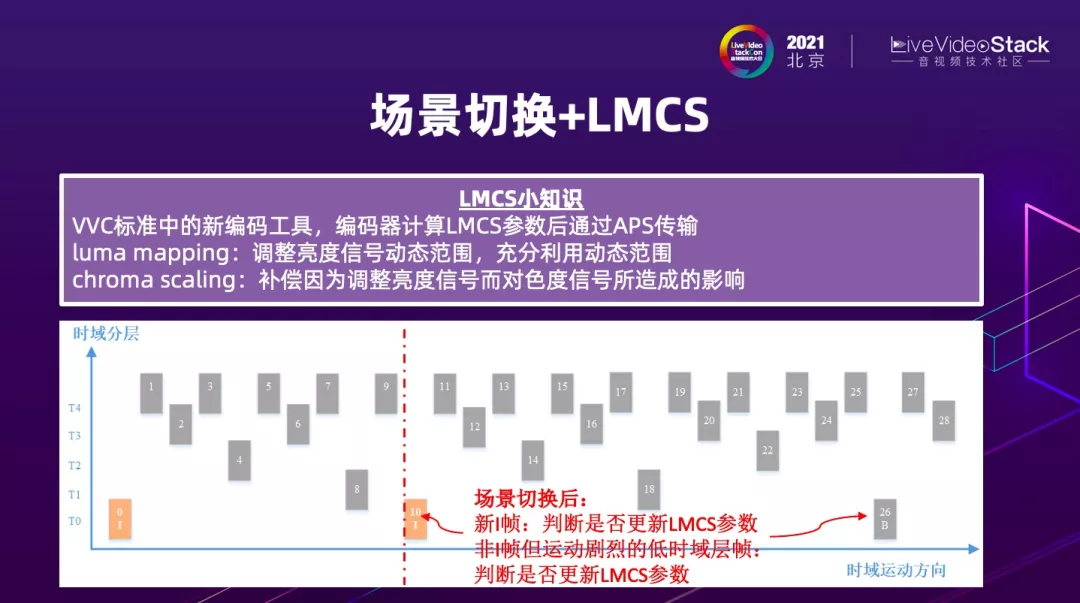

看一下场景切换和 LMCS 如何进行结合。

LMCS 是 VVC 中的新编码工具,需要编码器进行相应的参数计算,通过 APS 进行传输,这里 LM 指的是 luma mapping,调整亮度信号动态范围,让亮度信号更加充分利用动态范围,比如说 8bit 是 0-255 动态范围、10bit 是 0-1023 动态范围。

由于在 LM 过程中对亮度信号进行调整,需要进行 CS 过程,也就是 chroma scaling,对同一个块里面的色度信号做相应的调整,来补偿亮度信号调整对色度的影响。

此工具和场景切换如何结合呢?

用刚才那个例子,第十帧发现有场景切换,是新 I 帧,新场景的动态范围可能完全不一样了,因此会在新的 I 帧上判断是否需要进行 LMCS 参数更新,而且在相应的 GOP 预测结构改变后,新的帧会变成新的低时域帧,比如第 26 帧在 GOP16 情况下变成低时域帧,那么我们会对运动是否比较剧烈进行判断,如果运动剧烈,在低时域帧上也需要进行 LMCS 参数更新。

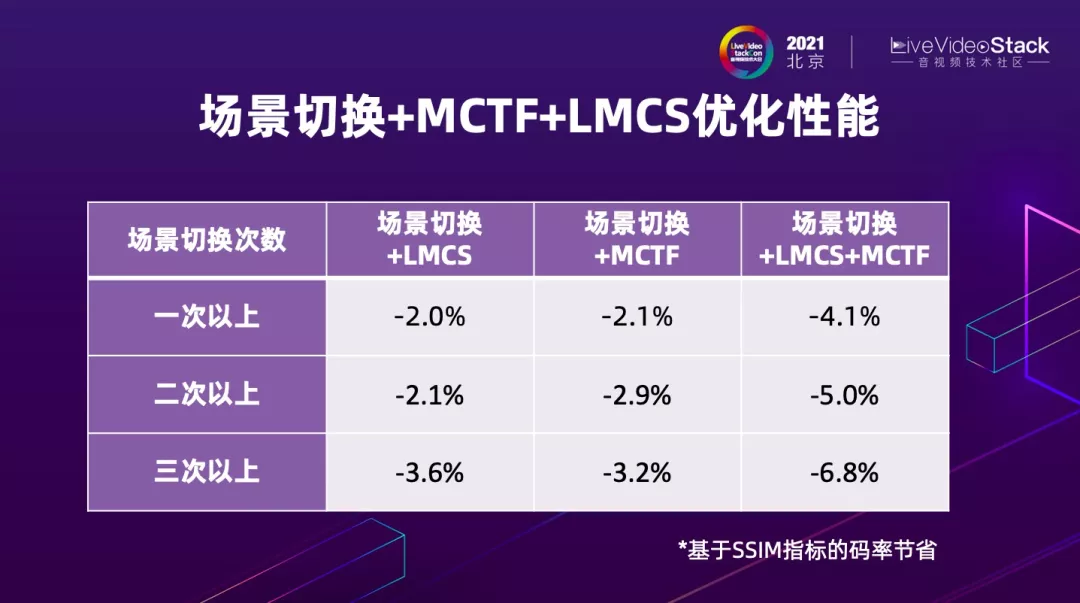

通过这样的优化,场景切换 + 前处理 MCTF+LMCS 联合优化能够拿到什么样的性能呢?

如果视频相当长,包括一次以上场景切换,如果单独与 LMCS 一起优化,可以达到 2% 的带宽节省;如果单独与 MCTF 一起优化,可以达到 2.1% 的带宽节省;如果三个同时进行优化,可以将性能完美叠加,得到 4.1% 性能增益。

如果一个视频中场景切换相当频繁,达到 2 次以上,表中可以看出有进一步性能提升,从单独优化分别达到 2.1% 和 2.9%,到三者同时优化拿到 5% 性能增益。

如果还有更加频繁的场景切换,那么这个联合优化的红利会更多,和 LMCS 进行结合,可以达到 3.6%;如果与 MCTF 结合,可以达到 3.2%;如果三者一起联合优化,可以得到 6.8% 的性能增益。

大家做编码器的同学都知道,6.8% 的性能相当可观,而我们可以通过预分析、前处理和核心编码工具的联合优化的方法拿到。

刚才主要介绍的是编码质量性能的优化,接下来会从第二个非常重要的维度去看怎样进行编码的速度优化。

编码速度优化

首先看一个示例:

VVC 非常有代表性的新工具是灵活的块划分结构,上图对比 VVC 和 HEVC 对同一个场景的划分对比,VVC 是左边,HEVC 是右边。在同一场景下,VVC 通过更加灵活的块划分可以更加好的对物体轮廓进行描述。

我们看一下放大图。拿 HEVC 来讲,由于只支持四分树划分,所以每一块都是正方形的。

VVC 允许更加灵活的在水平方向、竖直方向进行二分树(binary tree,BT)或三分树(ternary tree,TT)的划分。二分树和三分树统称为 MTT(mutli-type tree)。对比左边的放大图和右边放大图,通过长方形划分,VVC 对于手指描述更加精准。

虽然 VVC 用了更多的块划分方法得到更加好的物体轮廓描述,但是给编码器带来的困难是编码器需要尝试更加多的选择,因此怎么样加速 MTT 划分的决定对提升编码速度非常重要。

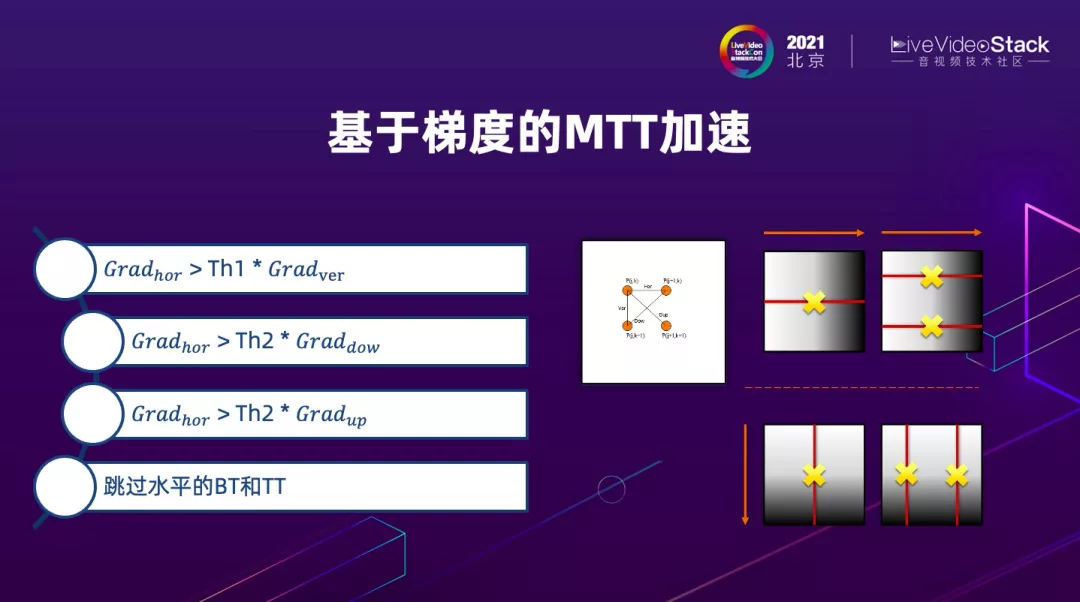

这里我们使用了基于梯度的 MTT 加速概念。如果一个块的纹理变化是在水平方向上比较剧烈,那么在水平方向进行划分的可能性就会降低,竖直划分也是一样的道理。

如果拿水平做例子,基于这个观察,对于每个块进行块划分的具体决策之前先会计算四个方向梯度,包括水平方向梯度、竖直方向梯度、和两个对角线上的梯度。

拿水平方向来讲,如果我发现水平方向梯度大于另外三个方向梯度,超过一定阈值,就说明当前块在水平方向的纹理变化比较激烈,因此编码器将不再进行水平的 BT 和 TT 的决策,加速编码时间。

我们可以看到,这个技术的加速效果从绝对帧率、编码器速度衡量来看,可以做到 14.8% 的提升,这个提速百分比相当可观。

当然,因为跳过了一些块划分的决策会造成性能下降,但是因为性能损失只有 0.4%,从整体加速与性能性价比来说,这个是非常完美的快速算法。

我们有其他非常多的优化工作,由于篇幅关系不一一多述。我来做一个 Ali266 编码器小结。

现在 Ali266 支持两大档次:

Slow 档次,主要适用于离线应用,对标 x265 veryslow 档次,Ali266 Slow 档次的编码速度和 x265 veryslow 一样,同时相比起 x265 veryslow 档次可以达到 50% 的码率节省,也就是带宽减半。

同时 Ali266 还支持对于商业化来说非常重要的 Fast 档次,对实时编码速度要求严格的商业应用,可以做到 720p30 帧每秒实时编码,在 VVC 编码器速度业界领先,对标的实时应用,与 x265 medium 档次相比,做到 40% 码率节省,是非常大的带宽红利。

从编码速度来说,我们并没有停留在 720p30,还在继续开发 2k 和 4k、8k 超高清视频实时编码能力。

另外,在准备此次的分享过程中,Ali266 已经做到了 2k,也就是 1080p30 帧每秒的实时编码能力,增加了我们挑战超高清实时编码的信心。

我们后续持续推进 Ali266 的主要目标是继续保持 VVC 的性能优势,加速 VVC 商业落地。

讲完编码器,我接下来讲一下解码器,因为我们之前讲到,开发 Ali266 的主要目标之一是提供完整的 VVC 编解码能力。

解码器设计目标从商用角度来说有以下几个,首先是实时解码速度,甚至比实时更快;其次是需要解码器非常稳定鲁棒;然后是 thin decoding 的概念,希望解码器比较轻。

为了实现这些设计目标,我们从 4 个方面进行了优化,其中一个非常重要的维度就是从零开始。

这个是说我们抛弃了之前所有的开源或者参考平台的架构设计、数据结构设计,从零开始,按照 VVC 标准文档开始进行完全全新的数据结构和框架设计,在设计过程中使用了大家比较熟悉的加速办法,包括多线程加速、汇编优化、内存和缓存效率优化等。通过这四个维度来提升 Ali266 解码器的性能。

上图罗列了从四个维度上 Ali266 解码性能。

从速度来说我们比较关注低端机(让 VVC 有普惠概念),然后在低端机测试上我们发现 Ali266 只需要三个线程就可以做到 720p 的实时解码,由于线程占用率较低,可以有效降低 CPU 占用率和手机的功耗,对于实际商用是相当有利的指标。

从稳定性的角度来说,我们进行了多款苹果手机和安卓手机的测试,覆盖了两大移动端操作系统,并且全面覆盖高中低三档移动端设备来保证稳定性。

从鲁棒性来说,我们使用了上万条错误码流来冲击 Ali266 解码器,保证其在无论是 slice 之上还是 slice 之下的出现错误,都能够有完美的快速错误恢复机制。

最后,正是由于我们从零开始,才能在 thin decoder 上给出一个满意的答案,我们的 Ali266 解码器包大小不到 1MB,而且在解码高清 720p 的时候,内存使用只需要 33MB。

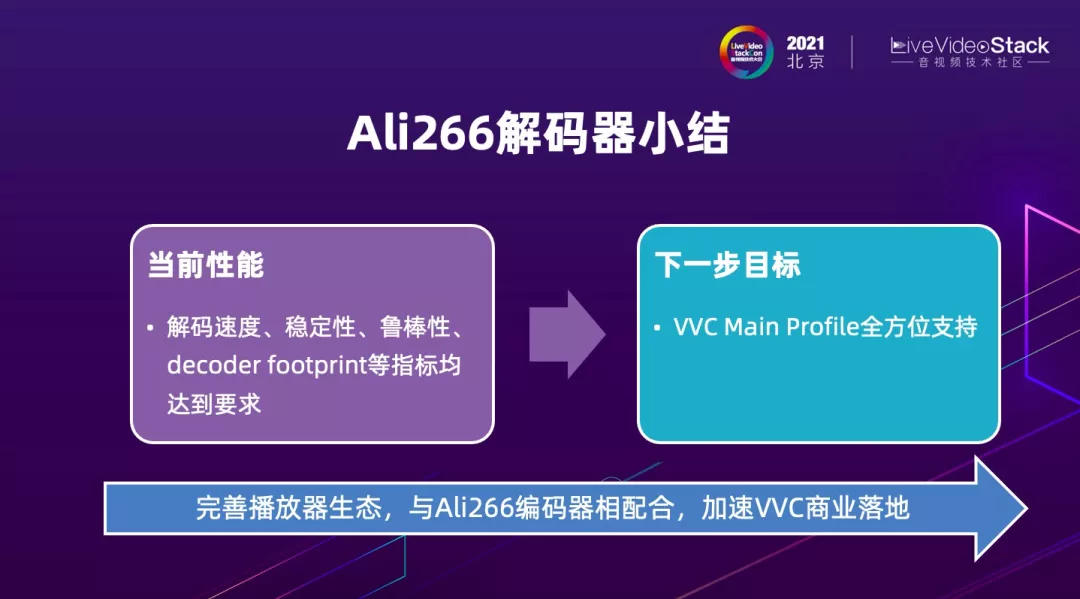

我来做了一个 Ali266 解码器的小结。

从当前性能来说,Ali266 的解码速度、稳定性、鲁棒性、decoder footprint 等指标均达到设计目标和商用要求,下一步我们希望对 VVC 进行 Main Profile 的全方位支持,主要指的是 10-bit 解码的全面支持。

另外,我们也会全力进行播放器生态的完善化,与 Ali266 编码器相配合,加速 VVC 商业落地。

既然之前我们多次提到了商业落地,接下来看一下对 Ali266 的业务展望。

3. Ali266 业务展望

首先来看 VVC 标准层面两到三年的落地展望。

与 HEVC 和之前的 H264 一样,VVC 是个通用标准,因此可以全面覆盖多种视频应用,包括点播、视频会议、直播、IoT 视频监控等已有的视频应用。

还有很多新兴视频应用在兴起中,包括全景视频、AR、VR、以及最近很火的元宇宙,这些应用也需要视频编解码的技术底座,因此对于这类新兴应用,VVC 标准也有普适性。

那么我们再来看一下 Ali266 的应用展望。

我们从阿里集团内开始,这里列了四点:优酷、钉钉视频会议、阿里云视频云、淘宝。

在整个如何推进 Ali266 应用上我个人的见解是会从闭环应用走到开放应用。为什么是这样的逻辑?

原因在于闭环业务下端到端可控性更强,在新标准生态还不够完善的时候可以通过闭环方法打通,这里面优酷和钉钉视频会议是比较完美的闭环业务示例。

在闭环打磨了 Ali266,并且走通从内容到播放的整体链路后,我们再去应对开放应用会更加 ready,更加成熟。我们开始推进大规模开放应用的时候,VVC 会有比较全面的移动端和端上硬解支持,那也将是真正大规模展示 VVC 标准压缩力的时候。

刚才讲到优酷,这里我与大家介绍一下优酷帧享,就是艺术家与科学家联手打造的超高清视听体验。

它依赖了几大非常重要的超高清技术指标,中间包括高帧率,60 帧到 120 帧每秒的高帧率,从空域分辨率角度来说,4K-8K 都在帧享范围内,动态范围来说帧享完全支持 HDR 高动态范围对比度和宽色域。而且,有影必须有音,优酷帧享还包括对 3D 环绕音效的支持。

另外一个优酷非常新颖的应用是优酷自由视角,它主要支持 Free ViewPoint Video(FVV),FVV 提供给用户很好的 Feature,因为它传递的视频格式是全景视频,用户可以自己用手在屏幕上进行滑动选择自己想要观看视角,从不同角度自由选择自己想看的内容,优酷的自由视角在 CBA 重大赛事以及《这就是街舞》大型的综艺节目里都有支持。

来看看 Ali266 能够给优酷带来什么样的价值,如何助力帧享分辨率提升、帧率、动态范围提升。

VVC 标准带来的带宽红利在 HDR 视频上超过 50%。对于帧享 8k120 帧 HDR 超高清体验是有非常好技术支撑。

全景视频自由视角方面,由于 VVC 原生支持 360 全景视频,能够更好的提升主观质量,帮助优酷在这方面孵化新业务。

另外,之前虽然没有提到,但是 VVC 和 HEVC 一样,也有 Still picture profile,因此可以帮助静态图片节省带宽和存储,因此优酷缩略图、封面图静态的场景也可以完美用到 Ali266 强大压缩能力。目前我们团队已经与优酷在进行深度合作,希望在不久的将来给大家汇报 Ali266 落地优酷的结果。

刚才讲了在过去一年中发生的事情,接下来看一下在后 VVC 时代视频业界看到的机遇和挑战。

4. 后 VVC 时代的机遇和挑战

这里分为两部分,技术和应用。从技术角度来说,每一代标准主要都在追求更高的压缩率,因此 VVC 并不是终点。

在对更高压缩率的探索上,包括在传统编解码框架下进行探索以及在 AI 技术支撑下对视频编解码框架和工具集的探索。从应用的角度来说,简单看一下新兴应用 AR、VR、MR、云游戏、元宇宙这几个新兴应用在后 VVC 时代提出的机遇和挑战。

更高的压缩力:框架之争

技术层面为了追求更高的压缩力,现在到了时间去看一直以来视频编解码标准所使用的框架在下一代是否会继续使用。

左边是一直以来几代视频标准以来的手工打造的视频编解码框架,包括不同的功能模块,块分割、帧内帧间编码、环路滤波等。

右边是全新 Learning based 的框架,完全通过 AI 方法学习,对于 encoder、decoder 通过全神经网络进行实现。

在传统框架下,JVET 标准委员会最近设立了 ECM(enhanced compression model)的参考平台,用于探索下一代编码技术。

当前 ECM 版本是 2.0,这个表中对比了 ECM2.0 与 VTM-11.0 的压缩性能,可以看出在亮度信号上 ECM2.0 已经可以做到 14.8% 的性能增益,色度信号上有更高的性能,encoder 和 decoder 复杂度也有一定上升,不过现在主要是推进压缩力,复杂度不是现阶段最关心的维度。

ECM 基于传统框架,大部分工具是之前开发 VVC 的时候已经看到过的,经过进一步的算法迭代和打磨,得到 14.8% 的性能增益。

AI 编码的状况分成两部分:端到端的 AI、以及工具集的 AI。

刚才的示例图显示,端到端的 AI 与传统框架完全不一样,采用全新框架。

以今天端到端 AI 能力来说,在单张图片的编码性能可以小幅超过 VVC,但如果考虑真正视频编码,也就是把时域维度也考虑进来,端到端 AI 的性能还是比较接近 HEVC,还有一定进步的空间。

另外 AI 技术还可以用来做工具集 AI,在不改变传统框架的前提下,在某些功能模块上开发 AI 编码工具,用以替换或叠加在已有传统编码工具之上,提升性能。

这部分比较多的例子是帧内编码和环内滤波工具。拿今天来说以我们所知,基于多神经网络模型的 NNLF 环路滤波技术相比 VVC,性能增益可以达到 10%。

AI 视频编码有其自己挑战,分为三个维度。

第一个挑战是计算复杂度,因为现在我们主要还是参数量换性能增益的概念,最近看到 Google 的 paper 给出量化的指导,如果一个 AI 工具可以提供个位数的性能增益,那么希望这个工具的参数量控制在 50K 的数量级上。今天很多 AI 工具的参数量在 500k 到 1 兆左右,还是与目标参数量还有数量级的差异,需要简化。另外,计算复杂度同时也包括需要考虑参数定点化,运算量尤其是乘法运算量这些维度。

第二个挑战是数据交互量,尤其是工具级 AI 与传统编码器的其它功能模块可能有很多像素级的交互,无论是帧级还是块级发生,对于编解码吞吐率都是很大的挑战。现如今所看到的性能较好的工具都依赖多神经网络模型,多 NN 模型需要模型调换,在模型参数量比较大的时候,调换模型所产生的数据交互量也对吞吐率提出挑战。

第三个挑战是移动端解码,大家手机看视频是很普遍的行为,如何在移动端做好解码,个人认为由于上面说到的数据交互量的原因,通过做解码器 + 外置 NPU 的方法不太可行,如果要做合一的解码器就要考虑硬件成本。

同一篇 Google 的 Paper 说一个传统解码器的成本相当于实现一个 2M 参数 MobileNet 模型的成本。我们知道 MobileNet 是比较轻量级的神经网络,如果一个 NNLF 滤波器需要 1M 参数的话,就是一半的解码器成本。所以成本上的下降需要更加努力去做到。所以说 AI 编码主要挑战总结下来就是需要做到更合理的性价比,这方面需要各个公司进行大量研发投入才有可能拿到合理性价比。什么时候能拿到合理的性价比,发挥 AI 视频编码的潜力,我们还是拭目以待。

最后我想说一个个人见解。

AI 编码有这样性价比挑战的一个原因是因为 AI 技术本来就是 Data Driven 的,在一个特定场景下的 Data Driven 更加容易设计,而主要的技术对于通用场景上的挑战一定更大。

因此我认为可以去看一下特定场景下的 AI 编码,可能会更快的提供技术和业务的突破机会。大家最近可能注意到 Facebook 和英伟达对人脸视频进行端到端 AI 编码,在这种特定场景下,在超低码率下,AI 编码对人脸清晰度恢复相比于传统方法来说可以有比较大的突破,显示了 AI 编码的潜力。

新兴应用

最后讲三个新兴应用的例子,AR/VR/MR、云游戏、元宇宙。前两者是元宇宙的一部分,所以我们看一下元宇宙。

首先来看一下什么是元宇宙。

最近 “元宇宙” 这个词兴起的时候,我自己不是很清楚到底是什么意思,所以我去查了一下。这是从纽约时报文章中摘出来的,什么叫 Metaverse 也就是元宇宙,纽约时报定义为虚拟的体验、环境、财产的混合模态。

这里给了五个元宇宙体现的例子,我们从最上面沿着逆时针方向看一下:如果你喜欢的游戏可以在其中去建立自己的世界,与他人交互,这是元宇宙的体现;如果最近参加过无论是因公(meeting)或因私(party),没有真人出现而是用数字的 avatar 出现,这也是元宇宙的体现;如果带了头盔或者眼镜去体验 AR、VR 所赋予的虚拟环境,也是元宇宙的体现;如果你拥有 NFT 或 crypto currency 这些虚拟财产,也是元宇宙的体现;最后我觉得比较有意思的一点是纽约时报认为绝大多数的社交网络也是元宇宙的体现,因为线上和线下的你不是完全一致,线上的你可能有一定虚拟的成分在,所以也是元宇宙的体现。

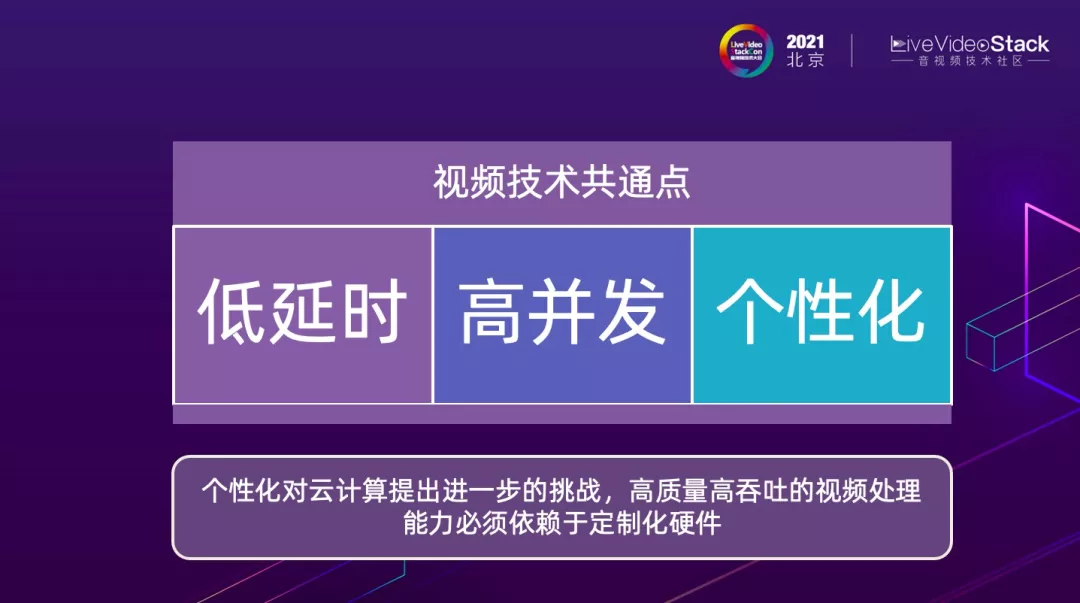

支持元宇宙和各种 AR/VR 体验从视频技术的角度来看有几大共同点:低延时、高并发、以及个性化。

前面这两点与现有应用的要求相类似,比如拿直播来说,也有低延时高并发的要求;但是第三点要求,就是个性化的要求,是一个完全不一样的全新技术支撑。

因为在这些虚拟场景下,每一个用户都在追求自己的体验和个性化的选择。从阿里云智能的角度来看,个性化对于云计算提出进一步挑战,更高的要求。我们今天支持一次直播有成千上万甚至上百万的并发量,一次下发服务很多客户。

但是,如果每个客户都有自己的个性化要求,每次下发只能支持十几或几十有类似要求的客户,那么对云上视频处理能力的质量和吞吐率都提出了更高的要求,要求处理能力有数量级上的提升。

所以我认为将来要对于视频处理和 deliver 做好技术支撑,云上定制化硬件是必然的技术趋势。

5. 总结

最后我们对今天的分享做一个总结。

首先我们介绍了 Ali266,阿里云自研的 VVC 编解码器,首先 Ali266 对 VVC 这个最新视频标准提供完整的编解码能力,速度可以达到实时高清,目前我们最快的速度是可以达到 1080p30 帧编码速度。

Ali266 压缩性能卓越,在 Slow 档次上达到 50% 的带宽节省,在实时 Fast 档次上达到 40% 的带宽节省,因此 Ali266 从质量优先到速度优先可以覆盖不同业务的需求。同时我们非常高兴的汇报我们正在与优酷进行深度合作,希望通过 Ali266 技术落地优酷,助力优酷降本增质、赋能新业务技术支撑。

展望未来的话,从技术上来说,下一代编解码标准还是需要拿到更好的压缩率,但是如何进行框架的选择我们还在探索,今天还没有定论。传统框架下的 ECM 相比 VVC 能拿到 15% 的性能增益,但与 40%、50% 的要求还有距离。AI 编码可以给出很好性能潜力,但是从性价比来说还没有达到要求,需要长足进步。

从应用角度来说,元宇宙会带给大家更加丰富的虚拟体验,也可以支撑很多新的应用的成长。要让元宇宙成为现实的话,在云计算的方面需要尽快实现高质量高吞吐的个性化云计算能力,应对新兴应用所提出的挑战。

最后,虽然之前没有提到,但是虚拟世界的体验也需要更加友好、也就是更轻更普惠的 AR/VR 终端设备早日登场。

本次分享到此结束,非常感谢大家,也特别要感谢主办方 LVS 给我这个机会做分享,由于疫情的影响,非常遗憾与大家不能进行面对面交流,如果对我此次分享的内容有任何问题或希望进一步探讨,欢迎大家在公众号后台留言。

「视频云技术」你最值得关注的音视频技术公众号,每周推送来自阿里云一线的实践技术文章,在这里与音视频领域一流工程师交流切磋。公众号后台回复【技术】可加入阿里云视频云产品技术交流群,和业内大咖一起探讨音视频技术,获取更多行业最新信息。

**粗体** _斜体_ [链接](http://example.com) `代码` - 列表 > 引用。你还可以使用@来通知其他用户。