INTERSPEECH 2024 论文预讲会由CCF语音对话与听觉专委会、语音之家主办,旨在为学者们提供更多的交流机会,更方便、快捷地了解领域前沿。本次论文预讲会按照技术领域投稿和实验室专场两种形式进行招募,欢迎大家投稿报名。

INTERSPEECH 2024 论文预讲会第四期邀请到华南理工大学电子与信息学院做本次会议的专场分享,欢迎大家观看。

第四期

华南理工大学电子与信息学院【专场】

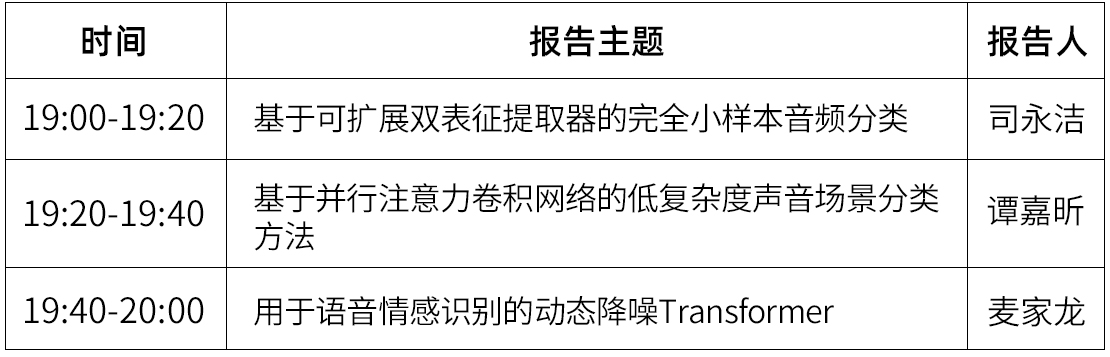

时间:7月12日(周五)19:00 ~ 20:00

形式:线上

议程:每位嘉宾分享20分钟(含5分钟QA)

嘉宾&主题

嘉宾简介:司永洁,华南理工大学电子与信息学院二年级博士生,研究方向为音频信号处理和机器学习。

报告题目:基于可扩展双表征提取器的完全小样本音频分类

摘要:在小样本类增量音频分类中,通常假设基础环节的训练数据是充足的。然而,由于某些类的数据稀缺,在一些实际场景中,很难在基础环节收集大量样本进行模型训练。论文探讨了一个在所有环节训练样本都很少的音频分类问题:完全小样本类增量音频分类(Fully Few-shot Class-incremental Audio Classification, FFCAC)。论文提出基于可扩展双表征提取器(Expandable Dual-embedding Extractor, EDE)的FFCAC方法。EDE由预训练的音频频谱图转换器(Audio Spectrogram Transformer, AST)和微调的AST拼接而成,可在增量学习过程中持续学习新类,同时提取区分性表征和泛化性表征从而提高模型分类性能。实验在三个公开数据集(LS-100、NSynth-100和FSC-89)上进行。结果表明,论文方法在平均准确率上超过了七个基线方法。

论文:https://arxiv.org/abs/2406.08122

代码:https://github.com/YongjieSi/EDE

嘉宾简介:谭嘉昕,华南理工大学电子与信息学院一年级硕士生,研究方向为语音与音频信号处理、机器学习。

报告题目 :基于并行注意力卷积网络的低复杂度声音场景分类方法

摘要:声场景分类是音频和声学信号处理领域的一个重要研究方向。其目标是将每个音频片段判决为预定义的声场景类别。卷积神经网络及其变体能有效提取局部上下文信息,但它不能有效提取全局上下文信息。上述两种信息具有互补性。论文设计一个并行注意力卷积网络,采用两个并行的网络分支分别提取局部与全局的上下文信息。此外,论文还采用了知识蒸馏、数据增广和自适应残差归一化等技术,进一步提升论文方法的声音场景分类准确率和降低论文方法的复杂度。实验结果表明,论文方法在DCASE 2023挑战赛的开发数据集上整体优于对比方法的性能。在训练不可见设备录制的音频片段上进行测试,论文方法也获得了更高的准确率。显著性检验的结果表明,不同方法的准确率存在不同的统计显著性差异。

论文:https://arxiv.org/abs/2406.08119代码:https://github.com/Jessytan/Low-complexity-ASC

嘉宾简介:麦家龙,华南理工大学电子与信息学院一年级硕士生,研究方向为语音与音频信号处理、机器学习。

报告题目:用于语音情感识别的动态降噪Transformer

摘要:语音情感识别(SER)是人机交互中的重要组成部分。最近,各种优化的Transformer变体已被应用于SER。然而,大多数研究使用样本中的所有信息,并倾向于忽略局部细节,这使得难以感知语音中局部存在的情感信息。虽然有研究探索如何利用局部信息,但它们的方法不够灵活或过于复杂。为了解决这些问题,我们提出了DropFormer,一种新的架构,它通过动态丢弃非情感信息从而只关注情感信息。DropFormer由两个主要组件组成:(1)Drop Attention,擅长捕捉局部情感并突出情感相关部分,(2)Token Dropout Module,能够丢弃缺乏情感信息的词。实验结果显示,我们的DropFormer在IEMOCAP和MELD基准上实现了最先进的性能。

参与方式

直播将通过语音之家微信视频号进行直播手机端、PC端可同步观看👇👇👇

预讲论文征集

INTERSPEECH 2024 论文预讲会按照技术领域投稿和实验室专场两种形式进行招募。

为了共创高质量的论文预讲会,我们诚挚邀请所有 INTERSPEECH 2024 作者参与到此次预讲会活动中来,也欢迎大家推荐适合此次预讲会活动的学者。

预讲论文报名方式

联系人邮箱:bd@speechhome.com

**粗体** _斜体_ [链接](http://example.com) `代码` - 列表 > 引用。你还可以使用@来通知其他用户。