INTERSPEECH 2024 论文预讲会由CCF语音对话与听觉专委会、中文信息学会语音信息专委会、语音之家主办,旨在为学者们提供更多的交流机会,更方便、快捷地了解领域前沿。本次论文预讲会按照技术领域投稿和实验室专场两种形式进行招募,欢迎大家投稿报名。

INTERSPEECH 2024 论文预讲会第七期邀请到清华大学语音与音频技术实验室做本次会议的分享,欢迎大家观看。

实验室概况

清华大学语音与音频技术实验室(SATLab)致力于研究语音、音频、音乐、听觉信息处理的理论、方法及其应用。主要研究方向为语音识别与分析、音频识别与分析、音乐与声学信号处理,机器学习等。实验室牵头承担了自然科学基金重点项目、国家重点研发课题等多个国家项目和企事业单位合作项目,并在多项语音技术方面国际最权威的评测中获得佳绩。

第七期

清华大学语音与音频技术实验室(SATLab)【专场】

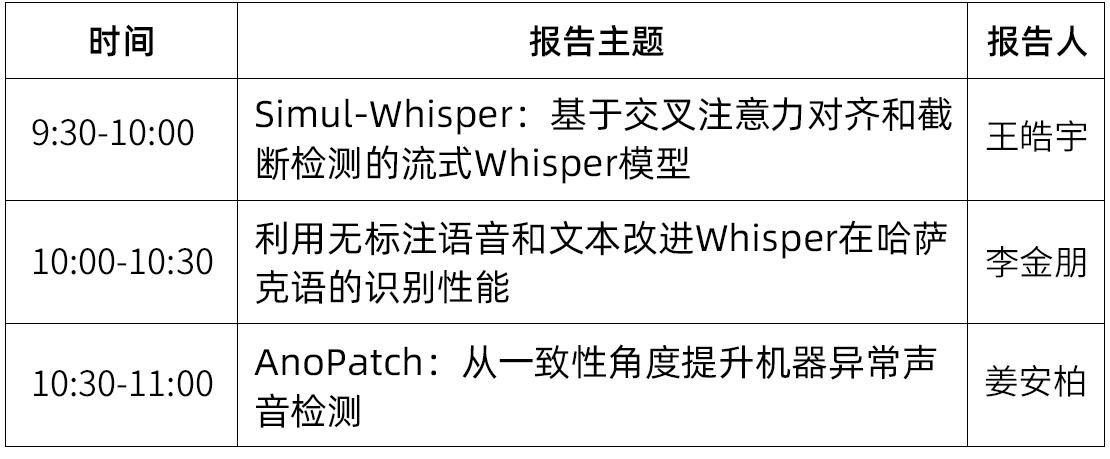

时间:8月17日(周六)9:30 ~ 11:00

形式:线上

议程:每位嘉宾分享30分钟(含5分钟QA)

嘉宾&主题

嘉宾简介:王皓宇,清华大学电子工程系硕士生,研究方向为低资源语音识别、流式语音识别和模型压缩。他在IEEE JSTSP期刊、INTERSPEECH等会议上发表多篇一作论文,并作为核心成员参加OpenASR21挑战赛获得多项冠军。

报告题目 :Simul-Whisper:基于交叉注意力对齐和截断检测的流式Whisper模型

摘要:Whisper是目前性能最好的多语种语音识别模型之一。凭借大规模数据集上的弱监督训练,Whisper模型在低资源、高噪声等复杂场景中有着突出的表现,然而其编码器-解码器结构使之难以用于流式语音识别。我们提出了Simul-Whisper方法,利用Whisper交叉注意力中隐含的时间对齐信息来指导自回归解码,无需对Whisper进行任何微调,就可以实现分块的流式语音识别。我们还引入了一个额外的CIF模型,以缓解在块边界发生的单词截断对识别结果产生的影响。我们在多个语种和多个Whisper架构上的实验显示,在块长1s的情况下,相比离线模型,流式的Simul-Whisper仅有平均1.46%的绝对WER损失,明显优于当前最优系统。

论文链接:https://arxiv.org/abs/2406.10052

代码链接:https://github.com/backspacetg/simul_whisper

嘉宾简介:李金朋,清华大学电子工程系硕士生,研究方向为语音大模型及小语种语音识别。他在ICASSP、INTERSPEECH等会议上发表多篇一作论文,作为核心成员参加OpenASR21挑战赛获得多项冠军,并参加发布GigaSpeech 2数据集。

报告题目:利用无标注语音和文本改进Whisper在哈萨克语的识别性能

摘要:Whisper等大规模语音识别模型在诸多任务的性能方面取得了显著进步。然而,它们在许多代表性不足的语言(如哈萨克语)上的表现并不令人满意。如何利用低成本数据提高 Whisper 在代表性不足的语言上的性能值得研究。在这项研究中,我们利用了易于获取的未配对语音和文本数据,并将哈萨克语的语言模型 GPT 与 Whisper 结合起来。我们采用了文本末尾判断修正和幻觉惩罚来提高语音识别的性能。此外,我们采用解码平均对数概率作为标准,从无标注的语音数据中选择样本,利用其伪标签对模型进行微调,以进一步提高模型性能。最终,我们在多个实验中提高了哈萨克语的识别性能,整个过程有望推广到其他代表性不足的语言。

论文地址:https://arxiv.org/pdf/2408.05554

嘉宾简介:姜安柏,清华大学电子工程系博士生,研究方向为音频信号处理及异常检测。他在ICASSP、INTERSPEECH等会议上发表多篇一作论文,作为核心成员获得DCASE 2024挑战赛获得异常声音检测赛道第一名。

报告题目:AnoPatch:从一致性角度提升机器异常声音检测

摘要:Large pre-trained models have demonstrated dominant performances in multiple areas, where the consistency between pre-training and fine-tuning is the key to success. However, few works reported satisfactory results of pre-trained models for the machine anomalous sound detection (ASD) task. This may be caused by the inconsistency of the pre-trained model and the inductive bias of machine audio, resulting in inconsistency in data and architecture. Thus, we propose AnoPatch which utilizes a ViT backbone pre-trained on AudioSet and fine-tunes it on machine audio. It is believed that machine audio is more related to audio datasets than speech datasets, and modeling it from patch level suits the sparsity of machine audio. As a result, AnoPatch showcases state-of-the-art (SOTA) performances on the DCASE 2020 ASD dataset and the DCASE 2023 ASD dataset. We also compare multiple pre-trained models and empirically demonstrate that better consistency yields considerable improvement.

论文地址:https://arxiv.org/pdf/2406.11364

参与方式

直播将通过语音之家微信视频号进行直播手机端、PC端可同步观看👇👇👇

预讲论文征集

INTERSPEECH 2024 论文预讲会按照技术领域投稿和实验室专场两种形式进行招募。

为了共创高质量的论文预讲会,我们诚挚邀请所有 INTERSPEECH 2024 作者参与到此次预讲会活动中来,也欢迎大家推荐适合此次预讲会活动的学者。

**粗体** _斜体_ [链接](http://example.com) `代码` - 列表 > 引用。你还可以使用@来通知其他用户。