ICASSP 2025 论文预讲会由CCF语音对话与听觉专委会、语音之家主办,旨在为学者们提供更多的交流机会,更方便、快捷地了解领域前沿。活动将邀请 ICASSP 2025 录用论文的作者进行报告交流。ICASSP 2025 论文预讲会第一期邀请到香港理工大学做本次会议的专场分享,欢迎大家观看。

第一期:香港理工大学【专场】

时间:3月4日(周二)19:30 ~ 20:30

形式:线上

议程:每位嘉宾分享20分钟(含5分钟QA)

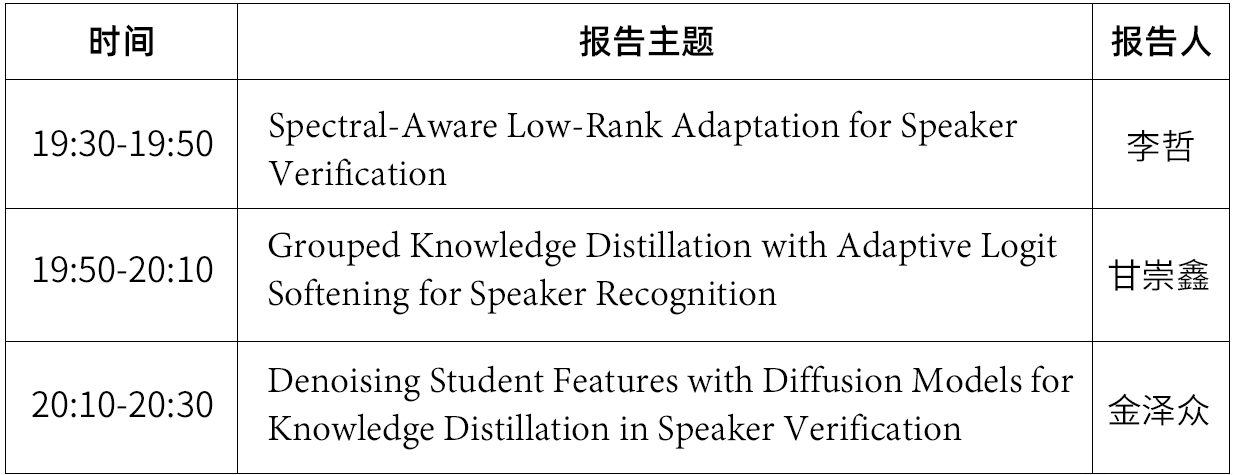

嘉宾&主题

嘉宾简介:李哲,香港理工大学电机及电子工程学系博士研究生,导师为Mak Man-wai教授。目前,他在微软亚洲研究院(MSRA)担任实习生,合作导师为刘树杰博士。他曾作为访问学生学者在美国斯坦福大学开展国际联合研究,合作导师为Mert Pilanci教授。李哲硕士毕业于新疆大学,导师为中国工程院院士吾守尔·斯拉木(Wushour Silamu)教授。他是IEEE会员及中国人工智能学会会员。在学术研究方面,李哲主持过1项研究生科研创新项目,并作为核心成员参与了多项国家重点研发计划、国家自然科学基金(NSFC)项目以及香港研究资助局(RGC)项目。此外,他已发表CCF会议、SCI、EI及中文核心期刊论文共计44篇,获得授权发明专利3项、软件著作权1项。他作为主要完成人荣获中国人工智能学会优秀科技成果奖,其参与的论文荣获PRICAI 2024的Best Student Paper Runner-Up Award。

分享主题:Spectral-Aware Low-Rank Adaptation for Speaker Verification

摘要:先前的研究表明,预训练模型的权重矩阵的主奇异向量能够捕捉到关键知识。而与小奇异值相关的向量则可能包含噪声或不可靠信息。因此,基于低秩适应(LoRA)的参数高效微调(PEFT)方法由于未对谱空间的使用施加约束,可能在需要高表征能力的任务中表现欠佳。在本研究中,我们通过将预训练权重矩阵的谱信息引入微调过程,改进了现有的PEFT技术。我们重点研究了基于谱适应的策略,特别是对顶部奇异向量的加性调整。具体而言,我们对预训练权重矩阵进行奇异值分解(SVD),并将微调限制在顶部谱空间内。通过在VoxCeleb1和CN-Celeb1数据集上进行的说话人验证实验表明,所提出的方法显著提升了微调性能。

论文链接:https://arxiv.org/abs/2501.03829

嘉宾简介:甘崇鑫,目前是香港理工大学电机及电子工程学系的一名博士研究生,IEEE学生会员, 导师是麦文伟教授。他硕士和本科分别毕业于香港理工大学电子及信息工程学系和郑州大学网络工程学系。目前,他是微软亚洲研究院多媒体计算组的一名实习生,研究工作聚焦于多模态的语音通用大模型。他的研究兴趣包括说话人识别、对比学习和声音事件检测。

分享主题 :Grouped Knowledge Distillation with Adaptive Logit Softening for Speaker Recognition

摘要:最近的研究表明,在知识蒸馏(Knowledge Distillation)过程中,将非目标说话者的信息与目标说话者的信息解耦,并随后对前者进行强调,可以显著提升性能。然而,一个经过良好训练的教师模型通常会生成接近零的非目标说话者后验概率,这对知识传递的贡献有限,从而导致知识蒸馏效果不佳。为了解决这一问题,我们提出了一种双组知识蒸馏(Dual-Group Knowledge Distillation)框架,其中,具有前k个说话者后验概率的主要组(Primary Group)捕捉了语音中大部分可以区分说话人的信息,而非主要组(Non-Primary Group)则通过主要组和非主要组之间的二元分类为知识蒸馏做出贡献。在此基础上,我们提出了Logit软化(Adaptive Logit Softening),用于调整教师和学生在二元蒸馏中的Logit,进一步促进了有效的知识传递。当使用简单的学生模型x-vector验证所提的方法时,我们发现在VoxCeleb1的三个测试集上取得了非常大的提升。

嘉宾简介:金泽众,香港理工大学电机及电子工程学系的博士研究生,导师为麦文伟(Mak Man-wai)教授。他硕士毕业于香港理工大学电子及电子工程系,并且是中国计算机学会会员。目前,他在微软亚洲研究院(MSRA)多媒体计算组进行序列生成方向的实习,合作导师为刘树杰博士。金泽众的主要研究方向包括声纹识别、序列生成、知识蒸馏和自监督学习。

分享主题:Denoising Student Features with Diffusion Models for Knowledge Distillation in Speaker Verification

摘要:近年来,预训练语音模型作为特征提取器在说话人验证(SV)中的应用逐渐增多。为了降低模型复杂度,研究者们通过将预训练模型的知识迁移至轻量级学生模型,使其性能超越传统方法。然而,由于模型容量差异,学生模型提取的特征往往包含更多噪声,导致教师模型与学生模型在中间层特征之间存在显著差异,这对特征级知识蒸馏(Knowledge Distillation, KD)产生了负面影响。针对这一问题,我们提出了一种基于扩散模型的特征去噪方法(DenoKD),以实现更有效的特征级蒸馏。实验表明,采用小型ECAPA-TDNN模型训练的DenoKD方法在VoxCeleb1-O测试集上的性能较基线提升了13%。此外,DenoKD机制在短语音测试场景下的声纹识别任务中也展现出显著优势。

参与方式

直播将通过语音之家微信视频号进行直播手机端、PC端可同步观看👇👇👇

预讲会征集

ICASSP 2025 论文预讲会面向全球线上招募,结合定向邀请与征集报名的方式,来选择预讲会的嘉宾。

为了共创高质量的论文预讲会,我们诚挚邀请所有 ICASSP 2025 作者参与到此次预讲会活动中来,也欢迎大家推荐适合此次预讲会活动的学者。

预讲会报名方式

联系人邮箱:bd@speechhome.com

联系人微信

**粗体** _斜体_ [链接](http://example.com) `代码` - 列表 > 引用。你还可以使用@来通知其他用户。