ICASSP 2025 论文预讲会由CCF语音对话与听觉专委会、语音之家主办,旨在为学者们提供更多的交流机会,更方便、快捷地了解领域前沿。活动将邀请 ICASSP 2025 录用论文的作者进行报告交流。

ICASSP 2025 论文预讲会第二期邀请到西北工业大学音频语音与语言处理研究组做本次会议的专场分享,欢迎大家观看。

第二期:西北工业大学音频语音与语言处理研究组【专场】

时间:3月7日(周五)19:00 ~ 20:30

形式:线上

议程:每位嘉宾分享30分钟(含5分钟QA)

嘉宾&主题

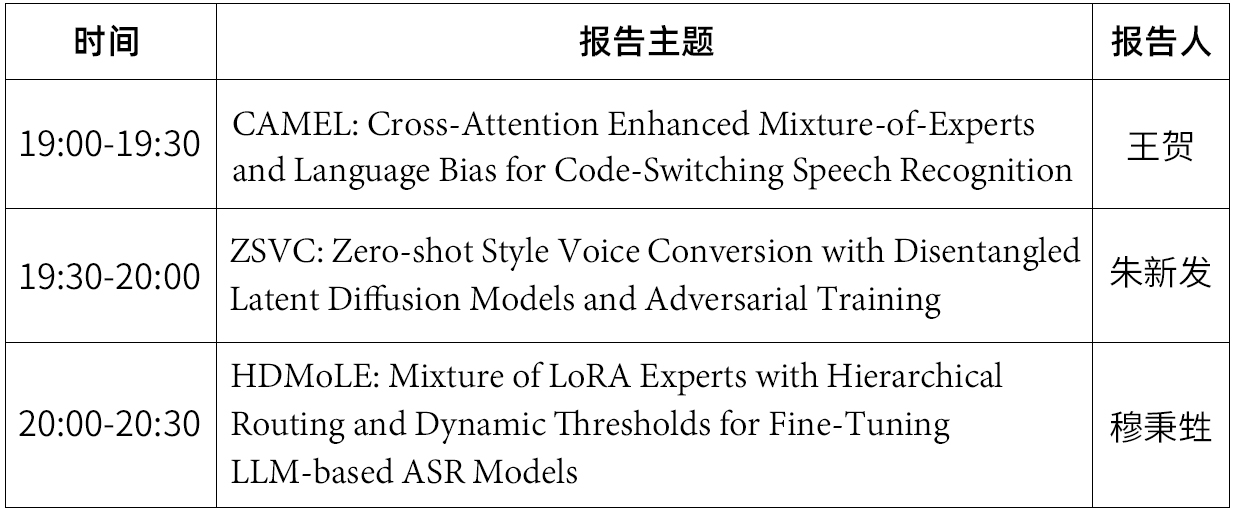

嘉宾简介:王贺,西北工业大学音频语音与语言处理研究组硕士二年级,研究方向为语音识别与理解,包括中英混语音识别、多通道语音识别、音视频语音识别等。在ICASSP、ICME等语音领域顶级会议发表一作论文五篇,国家奖学金获得者,国内外多个语音识别相关竞赛冠军。

分享主题:CAMEL: Cross-Attention Enhanced Mixture-of-Experts and Language Bias for Code-Switching Speech Recognition

摘要:语种混杂语音识别 (Code-Switching ASR) 旨在准确转录包含两种或多种语言的语音。为了更好地捕捉特定语言的语音表征并解决语种混杂ASR中的语言混淆问题,目前常用的方法有混合专家 (MoE) 架构以及语言日志 (Language Diarization) 解码器。然而,对于如何融合混合专家建模的不同语种表征以及从语言日志解码器引入语种信息,大多数研究仍在采用加权求和或拼接的方式。因此,找寻更好的融合方式或许是解决语言混淆问题、提高语种混杂ASR准确率的一条可行之路。在本研究中,我们提出了一种利用交叉注意力 (Cross Attention) 作为融合方式,结合了混合专家和语言日志的语种混杂 ASR 方法——CAMEL。在每个混合专家层后,我们利用交叉注意力强大的上下文和互信息建模能力,融合不同特定语言的语音表征。同时,我们用源注意力 (Source Attention) 取代了拼接,更高效地将来自语言日志解码器输出的语言信息融入到文本嵌入 (Text Embedding)。实验结果表明,我们提出的方法在 SEAME、ASRU200、ASRU700 + LibriSpeech460 三个中英语种混杂 ASR 数据集上均取得了 SOTA 的性能。

论文链接:https://arxiv.org/abs/2412.12760

嘉宾简介:朱新发,西北工业大学音频语音与语言处理研究组三年级硕士生,研究方向为语音理解与生成,包括表现力语音合成、基于语言模型的语音生成与语音理解等。在IEEE Trans. ASLP、ACM Multimedia、ICASSP、ICME等语音顶级期刊或会议发表一作及合作论文数十篇,国家奖学金获得者。

分享主题 :ZSVC: Zero-shot Style Voice Conversion with Disentangled Latent Diffusion Models and Adversarial Training

摘要:语音风格转换旨在将源语音的说话风格转换为所需的风格,同时保留原始的音色和语义内容。然而,现有的语音风格转换研究多聚焦于将风格与音色同时转换,且通常只涉及有限的风格类型。实际应用中,用户通常希望在保持原有音色特点的基础上,灵活地进行任意风格的转换。在本研究中,我们提出了一种新颖的零样本风格语音转换方法 ZSVC,该方法利用语音编解码器和具有语音提示机制的潜在扩散模型来促进语境学习,进行说话风格转换。为了解开说话风格和音色的耦合,我们引入了信息瓶颈来过滤源语音中的说话风格,并使用不确定性建模自适应归一化 (UMAdaIN) 来扰动风格提示中的说话者音色。此外,我们提出了一种新颖的对抗性训练策略来增强语境学习并提高风格相似性。对 44,000 小时语音数据进行的实验证明了 ZSVC 在零样本场景中生成多种说话风格的语音方面的卓越性能。

论文链接:https://arxiv.org/abs/2501.04416

嘉宾简介:穆秉甡,西北工业大学音频语音与语言处理研究组三年级博士生,研究方向为语音识别,包括多通道语音识别、口音语音识别、多模态语音识别等。在IEEE SPL、ICASSP、INTERSPEECH等语音期刊或会议发表一作及合作论文八篇。

分享主题:HDMoLE: Mixture of LoRA Experts with Hierarchical Routing and Dynamic Thresholds for Fine-Tuning LLM-based ASR Models

摘要:将大型语言模型(LLM)与自动语音识别(ASR)相结合的最新进展在通用语音领域表现出色。虽然对已有的LLM-ASR模型所有参数进行有监督的微调通常可以使其适应特定语音领域,但这种做法会带来很高的计算成本,并且也会显著降低了它们在通用语音领域的性能。在本文中,我们提出了一种新颖的参数高效多领域微调方法HDMoLE,用于将已有的LLM-ASR模型适应于多口音语音领域而不会在通用语音领域发生灾难性遗忘。该方法利用分层路由和动态阈值策略将低秩适应(LoRA)与混合专家(MoE)相结合,可以推广到任何线性层。分层路由在LoRA专家与特定口音领域之间建立了明确的对应关系,并且增强了LoRA专家之间的跨领域协作能力;动态阈值改进了传统MoE中静态Top-K专家选择策略,可以在MoE层自适应地激活不同数量的LoRA专家。我们在多口音和标准普通话数据集上验证了HDMoLE的有效性,在仅微调少量参数的情况下,HDMoLE在多口音语音领域取得了与全量微调相似的性能,并且在通用语音领域的性能损失较小。

论文链接:https://arxiv.org/abs/2409.19878v3

参与方式

直播将通过语音之家微信视频号进行直播手机端、PC端可同步观看👇👇👇

预讲会征集

ICASSP 2025 论文预讲会面向全球线上招募,结合定向邀请与征集报名的方式,来选择预讲会的嘉宾。

为了共创高质量的论文预讲会,我们诚挚邀请所有 ICASSP 2025 作者参与到此次预讲会活动中来,也欢迎大家推荐适合此次预讲会活动的学者。

预讲会报名方式

联系人邮箱bd@speechhome.com

**粗体** _斜体_ [链接](http://example.com) `代码` - 列表 > 引用。你还可以使用@来通知其他用户。