ICASSP 2026 论文预讲会由CCF语音对话与听觉专委会、语音之家主办,旨在为学者们提供更多的交流机会,更方便、快捷地了解领域前沿。活动将邀请 ICASSP 2026 录用论文的作者进行报告交流。

ICASSP 2026 论文预讲会邀请到武汉大学智能声学与语音处理实验室(IASP-Lab)在2月9日和2月10日分别做两期专场分享,本文介绍第一场相关内容,欢迎大家预约观看。

实验室概况

武汉大学智能声学与语音处理实验室Intelligent Acoustics and Speech Processing Lab (IASP-Lab)致力于通过人工智能和声学技术的创新,推动语音交互和声学感知的智能化发展,赋能新一代通信和智能交互应用。

第二期-武汉大学智能声学与语音处理实验室(一)【专场】

时间:2月9日(周一)19:00 ~ 21:00

形式:线上

议程:每位嘉宾分享30分钟(含5分钟QA)

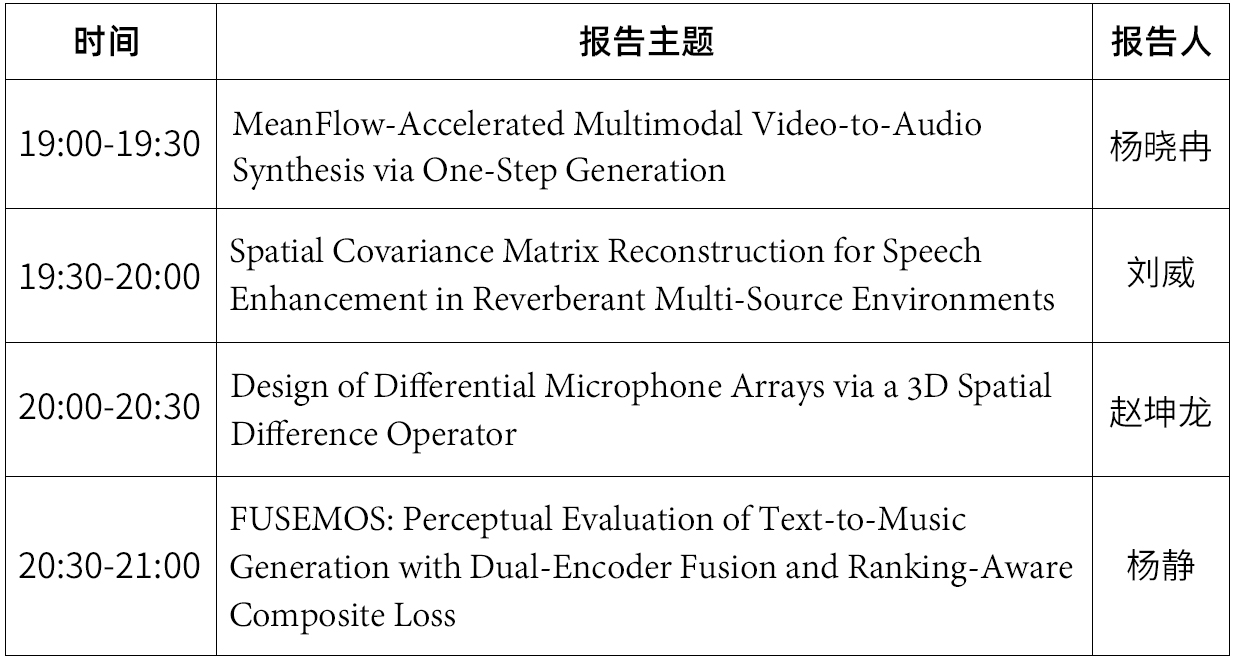

嘉宾&主题

嘉宾简介:杨晓冉,武汉大学电子信息学院硕士研究生二年级,导师为黄公平教授。主要研究方向为音效生成和多通道语音增强。目前已有 9 篇学术论文被 IEEE TASLP、ICASSP、AAAI、Interspeech 等国际期刊和会议接收,其中包括以第一作者身份发表的 IEEE TASLP 论文 1 篇及语音领域顶会 ICASSP 论文 2 篇。曾荣获第三届“声华杯”全国声学技术竞赛冠军、ICASSP 2026 XACLE Challenge 第四名以及“挑战杯”国家级三等奖等荣誉。

分享主题:MeanFlow-Accelerated Multimodal Video-to-Audio Synthesis via One-Step Generation

摘要:难以兼顾生成质量与推理效率是多模态音频生成任务的一大难题。以基于流匹配(Flow Matching)的模型为例,其核心在于对瞬时速度进行建模,本质上需要多步迭代采样,从而严重拖慢了推理速度。为突破这一效率瓶颈,我们提出了基于MeanFlow的加速生成模型。通过对平均速度场进行建模,我们实现了推理时的一步生成(one-step generation)。这一改进在大幅提升推理速度的同时,依然保持了良好的音效质量,并确保了语义对齐与时间同步性。针对无分类器引导(CFG)应用时易出现的一步生成失真问题,创新引入标量重缩放机制,通过精准平衡有条件与无条件预测,有效缓解失真现象。实验验证表明,该模型在实现推理速度跃升的同时,可稳定保持优质的音效输出,且确保音视频语义对齐与时间同步性,综合性能处于领域领先水平。

论文链接:https://arxiv.org/abs/2509.06389Demo

链接:https://vta888.github.io/MF-MJT/

嘉宾简介:刘威,武汉大学电子信息学院博士研究生三年级,导师为黄公平教授,合作导师为陈景东教授和Shoji Makino教授。他的主要研究兴趣是麦克风阵列、语音增强和声场分析。受国家留学基金(CSC)资助在日本早稻田大学进行访学。曾在OPPO北京研究所音频算法研发岗位实习,作为核心成员参与了多项校企联合研究项目和国家自然科学基金项目。获ICASSP 2026 Grand Challenge雷达声学语音增强(RASE)国际挑战赛冠军。担任包括IEEE Signal Processing Letters、Circuits, Systems, and Signal Processing、ICASSP 等期刊和会议的审稿人。以第一作者身份在IEEE TASLP 、ICASSP 等国际期刊和会议上发表论文4篇。

分享主题 :Spatial Covariance Matrix Reconstruction for Speech Enhancement in Reverberant Multi-Source Environments

摘要:本文提出了一种在线的空间协方差矩阵(SCM)重构方法,以提升多通道语音增强在复杂声学环境中的性能。传统的语音增强方法,如固定/自适应波束形成与多通道维纳滤波(MWF),均高度依赖于对目标声源、噪声和混响等空间协方差信息的准确估计。然而,现有SCM估计方法通常需要离线处理,计算开销较大,难以满足实时应用需求。为克服上述瓶颈,本文提出基于多个预定义的空间相干矩阵的线性建模方法。这些相干矩阵分别描述多个声源、晚期混响与环境噪声的空间结构。通过估计对应的组合权重,可刻画各声学成分在混合信号中的相对贡献。此外,本文采用基于Frobenius范数最小化的优化策略,从而在实时更新中稳定求解方差比;利用估计出的SCM重构结果推导多通道维纳滤波器,实现语音增强。实验结果表明,所提出的在线 SCM 重构方法能够有效刻画多源、混响与噪声的空间结构,并显著提升 MWF 的增强性能。

嘉宾简介:赵坤龙,武汉大学电子信息学院一年级博士研究生,导师为黄公平教授。主要研究方向为差分麦克风阵列设计、稳健波束形成器设计等。作为核心成员参与了多项校企联合研究项目和国家自然科学基金项目,担任包括IEEE Signal Processing Letters; Circuits, Systems, and Signal Processing; ICASSP 等期刊和会议的审稿人。目前以第一作者身份在Signal Processing, IEEE SPL, ICASSP, InterSpeech等国际期刊和会议上发表论文5篇。

分享主题:Design of Differential Microphone Arrays via a 3D Spatial Difference Operator

摘要:差分麦克风阵列(DMAs)能够测量并响应声场的空间导数,这使其在高保真声学信号采集和声场测量方面具有巨大潜力。以往关于三维(3D)麦克风阵列的研究主要基于声场的球谐分解,这必然限制了阵列拓扑结构为球形结构。本文根据有限差分近似原理提出了更灵活的三维差分麦克风阵列和波束形成设计方法,为麦克风设计和声场测量提供了新的见解。通过泰勒级数展开,我们展示了如何利用麦克风信号之间的有限差分来近似声场的空间导数,为三维差分麦克风阵列奠定了基础。基于这些公式,通过空间差分算子(SDO)进行的差分波束形成方法也可以扩展到三维情况。实验结果证实了所提出方法的有效性。

嘉宾简介:杨静,武汉大学电子信息学院二年级硕士研究生,导师为黄公平教授。主要研究方向为模拟人类偏好的感知评估方法及其在强化学习中的应用,以第一作者的身份在ICASSP会议上发表一篇论文,并在ICASSP 2026 Cadenza Challenge: Predicting Lyric Intelligibility中荣获第三名。

分享主题:FUSEMOS: Perceptual Evaluation of Text-to-Music Generation with Dual-Encoder Fusion and Ranking-Aware Composite Loss

摘要:生成音乐的感知评估是推动文本到音乐(TTM)生成系统发展的关键环节。尽管现有自动评估方法依赖音频-文本预训练模型(如CLAP)提取特征并预测人类标注的平均意见分数(MOS),但其普遍采用单一编码器架构,难以同时兼顾语义对齐与音乐结构的精细表达。为此,本文提出FUSEMOS,一种基于双编码器融合的感知评估框架,通过结合CLAP在跨模态语义对齐上的强表达能力与MERT在大规模音乐数据上预训练所获得的丰富结构建模能力,实现对音乐内容的多维度建模。该框架采用晚期融合机制,在得分层级进行融合,从而兼顾不同编码器的特性与互补性。为更好地匹配人类主观判断的排序偏好,本文进一步引入一种复合损失函数,融合截断回归与对比排序损失,在降低评分误差的同时增强模型对相对质量关系的敏感度。在MusicEval数据集上的实验验证了FUSEMOS在整体音乐印象(OMI)与文本对齐(TA)两个任务上的卓越性能,为TTM系统的自动化评估提供了更可靠、更贴近人类感知的新范式。

参与方式

直播将通过语音之家微信视频号进行直播手机端、PC端可同步观看👇👇👇

预讲会征集

ICASSP 2026 论文预讲会面向全球线上招募,结合定向邀请与征集报名的方式,来选择预讲会的嘉宾。

**粗体** _斜体_ [链接](http://example.com) `代码` - 列表 > 引用。你还可以使用@来通知其他用户。