问题描述

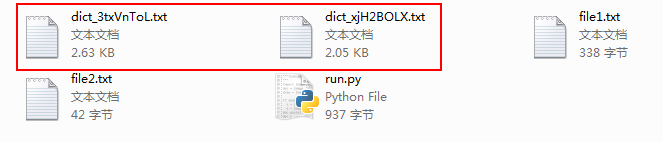

手上有两个字典文件,file1,file1

需要根据这两个字典文件生成一个新的文件

file1文件内容为

zhangwei

wangwei

wangfang

liwei

lina

zhangmin

lijing

wangjing

liuwei

wangxiuying

zhangli

lixiuying

wangli

zhangjing

zhangxiuying

liqiang

wangmin

limin

wanglei

liuyang

wangyan

wangyong

lijun

zhangyong

lijie

zhangjie

zhanglei

wangqiang

lijuan

wangjun

zhangyan

zhangtao

wangtao

liyan

wangchao

liming

liyong

wangjuan

liujie

liumin

lixia

lili

......file2的文件内容为

123

123456

@123

888

999

666

2015

2016

521需要file1+file2,生成类似

zhangwei123

zhangwei123456

zhangwei@123

zhangwei888

zhangwei999

zhangwei666

zhangwei2015

zhangwei2016

zhangwei521

wangwei123

wangwei123456

wangwei@123

wangwei888

wangwei999

wangwei666

wangwei2015

wangwei2016

wangwei521

wangfang123

wangfang123456

wangfang@123

wangfang888

wangfang999

wangfang666

wangfang2015

wangfang2016

wangfang521的字典文件

目前我这样写的

#!/usr/bin/env python

# -*- coding: utf-8 -*-

f = open('zidian.txt','w')

with open('file1.txt','r') as username:

for user in username:

print user

with open('file2.txt','r') as dict:

for dic in dict.readlines():

f.write(user.strip()+dic.strip('\r')+'\n')

但是这样写有个弊端,就是生成的字典文件太大

目前想改一下,改成file1+file2的一到五行,生成一个文件,file1+file2的6到10行,在生成一个,一次循环直到循环完file2

求大牛教育教育怎么改

這裡是不求切割文件的作法,

itertools.product可以幫你完成地更簡潔:切割輸出的做法:

稍微說一下你原本代碼的一些問題:

f = open('zidian.txt','w')你在這裡 open 了文件可是卻忘記關閉了, 讀寫文件還是使用 with 的作法會比較好dict.readlines(), 若非萬不得已, 不要使用readlines, 千萬記得!! 請參考這篇文章 文本格式轉換代碼優化另外,

dic或dict這個字, 在 python 中有著獨特的意義, 稍微有點經驗的 python programmer 都會認為他們是 python dictionary, 這容易造成誤會我回答過的問題: Python-QA