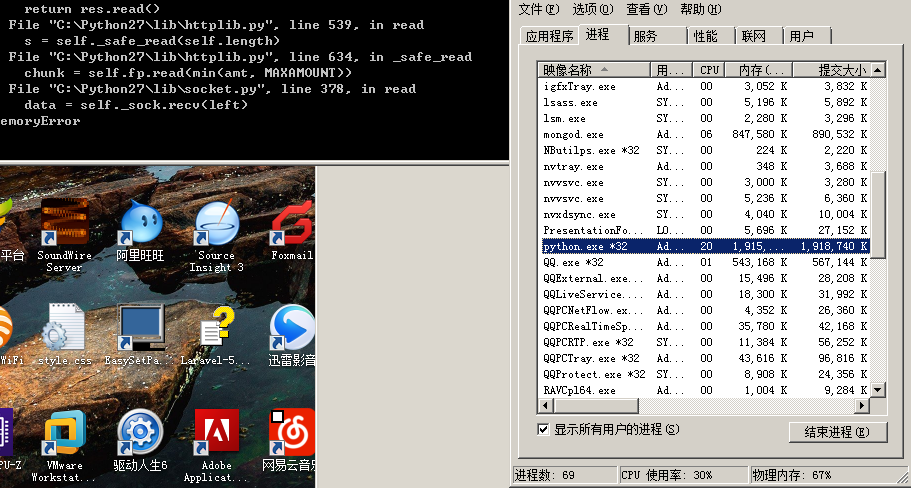

RT,我最近写一个爬虫,需要从一个网站抓取大量数据,先用开启十个线程使用httplib模块从一个list页面中获取大概一百多万条id,塞入一个queue队列中,然后再开十个线程使用httplib模块从刚才那个queue队列中取出id,通过这些id再去一个view页面把正文内容抓取出来写入mongo数据库,但是现在发现只要python进程内存占用达到1.9G之后httplib模块就开始报内存溢出错误,请问这是什么原因?(我现在初步猜测是queue中存了几百万的id数据导致内存占用过多,httplib模块申请不到内存了)有什么办法可以解决吗?(因为访问那个list页面需要带上cookie,所以我才用httplib模块,如果有其他模块可以带上cookie发起请求的话也麻烦告诉我一下),求高人指点,感激不尽

撰写回答

你尚未登录,登录后可以

- 和开发者交流问题的细节

- 关注并接收问题和回答的更新提醒

- 参与内容的编辑和改进,让解决方法与时俱进

推荐问题

Spring中的两个疑惑?

使用注解的写法是否违背了Spring诞生的初衷?看了很多Spring教程,在讲述为什么要使用Spring的时候,都提出了一个很重要的原因就是,以前的8 回答6.5k 阅读

字节的 trae AI IDE 不支持类似 vscode 的 ssh remote 远程开发怎么办?

尝试一下字节的 trae AI IDE ([链接])安装后导入 vscode 的配置,好像一起把 vscode 的插件也导入了也能看到 vscode 之前配置的 ssh remote 但是连不上看到「输出」如下⬇️ {代码...}2 回答4.3k 阅读✓ 已解决

DataCap 中验证码无法显示,后台出现 NullPointerException 错误?

2 回答858 阅读✓ 已解决

如何使用 python 代码实现迅雷磁力链接资源的下载?

很多磁力链接,只有使用迅雷客户端才能下载有速度但是迅雷客户端没有可操作的 sdk如果我有很多的磁力链接,需要下载,且需要指定每个磁力的下载位置等等操作,怎么实现自动化和批量化?1 回答4.1k 阅读✓ 已解决

诺依框架自动生成代码前端Vue3提交数据,后端Java没收到问题出在哪里?

使用诺依框架自动生成代码功能。前端在请求地址处打印提交数据(有数据)如下图,后端Debug模式,进入断点查看数据如下图所示(无数据),问题一般出在哪里?========== Payload ===========4 回答697 阅读✓ 已解决

如何实现一个深拷贝函数?

在项目开发中,如何实现一个深拷贝函数?3 回答849 阅读✓ 已解决

请问,FastAPI如何获取到前端上传的二进制文件并且返回?

使用FastAPI想要获得前端上传的数据(是一个二进制文件): {代码...} 但是我直接返回,这里是报错:请问,FastAPI如何获取到前端上传的二进制文件并且返回(可以对其进行打印)?2 回答2.2k 阅读✓ 已解决

你的python是32位进程,32位进程的内存地址空间是4GB,其中只有2GB给用户进程使用,另外的2GB内核保留。改用64位Python能缓解这个问题。不过最好的办法是限制一下开多进程,每个进程限制一下线程数量,不要太多。其实总的线程数达到CPU内核两倍左右性能是最好的,并不是多多益善。

另外尽量节约内存使用,不要什么都整个读到内存里,大块变量尽量复用,不要过多拷贝。