我在scrapy的settings中设置了LOG_LEVEL = 'INFO',但我用CrawlerProcess将多个项目在一个进程中运行的时候,日志显示为DEBUG,这是为什么?'INFO'比较省些资源吧?

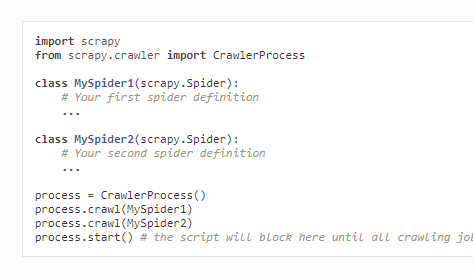

用的是官网的第一个案例,

类似这样,再运行该文件。

scrapy 明明在settings中设置 'INFO',但用CrawlerProcess运行的时候,为什么是DEBUG?

阅读 5.9k

撰写回答

你尚未登录,登录后可以

- 和开发者交流问题的细节

- 关注并接收问题和回答的更新提醒

- 参与内容的编辑和改进,让解决方法与时俱进

推荐问题

字节的 trae AI IDE 不支持类似 vscode 的 ssh remote 远程开发怎么办?

尝试一下字节的 trae AI IDE ([链接])安装后导入 vscode 的配置,好像一起把 vscode 的插件也导入了也能看到 vscode 之前配置的 ssh remote 但是连不上看到「输出」如下⬇️ {代码...}2 回答4.9k 阅读✓ 已解决

DataCap 中验证码无法显示,后台出现 NullPointerException 错误?

2 回答1k 阅读✓ 已解决

如何实现一个深拷贝函数?

在项目开发中,如何实现一个深拷贝函数?3 回答1k 阅读✓ 已解决

发现深拷贝和浅拷贝效果一致:请问一下有什么区别呢?

发现深拷贝和浅拷贝效果一致: {代码...} 请问一下有什么区别呢?4 回答822 阅读✓ 已解决

Python 成员变量在多个子类实例间共享,如何避免?

请教一下,Python版本为3.9.6,然后运行如下的代码,为什么会出现SlaveTwo类的对象modelTwo打印自身的成员变量storeDataArr的结果是['data1', 'data2'],不应该是['data2']?3 回答1.1k 阅读✓ 已解决

为什么 Qwen2.5-Omni-7B 官方教程都报错 Cannot import available module of Qwen2_5OmniModel in modelscope ?

官方教程:[链接]且安装了最新的 modelscope 版本 {代码...} 运行官方文档中的 demo 代码 {代码...} 但是报错了 {代码...} 让我很是无语1 回答1.6k 阅读✓ 已解决

Spark-TTS-0.5B 的 requirements.txt 在哪里?

[链接]我都真找不到这个 requirements.txt 文件在哪里1 回答1.1k 阅读✓ 已解决

请加载设置

这个代码示例是展示直接运行爬虫,运行爬虫项目需加载项目设置